KI-Bildgeneratoren im Jahr 2026 trainieren: Der ultimative Leitfaden

Zuletzt aktualisiert: 2026-01-22 18:08:26

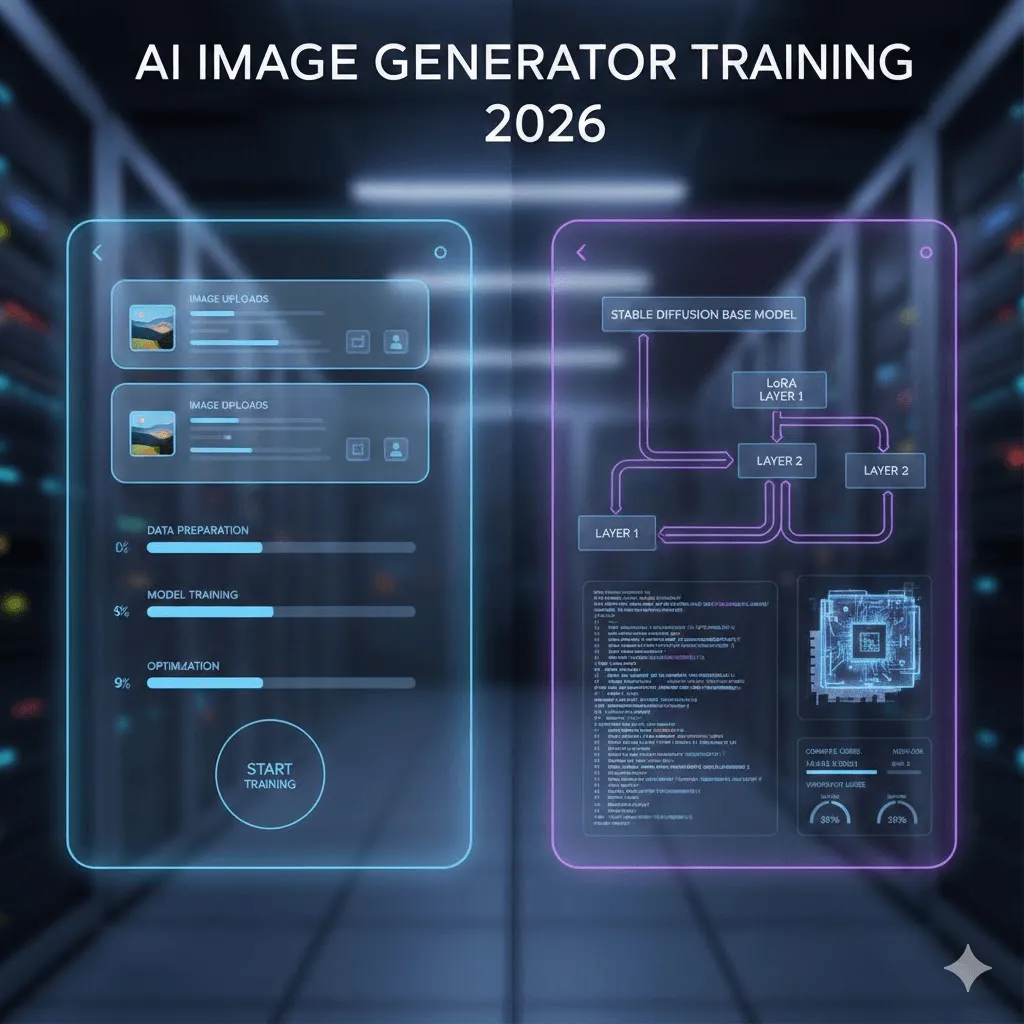

Das Trainieren von KI-Bildgeneratoren ist im Jahr 2026 längst keine reine Forscherdisziplin mehr: Wo früher noch tiefgreifendes Expertenwissen im Bereich Machine Learning, teure Hardware und wochenlange Experimente nötig waren, lassen sich heute mit der richtigen Strategie bereits in unter einer Stunde – teils sogar in weniger als 20 Minuten – beeindruckende Ergebnisse erzielen.

Allerdings ist „KI-Training“ nicht gleich KI-Training, da sich die verfügbaren Ansätze in puncto Effizienz und Flexibilität deutlich unterscheiden: Während schnelle, kostengünstige Methoden oft an funktionale Grenzen stoßen, bieten Verfahren für maximale Kontrolle zwar volle Gestaltungsfreiheit, bringen jedoch erhebliche technische Hürden mit sich. Dieser Leitfaden analysiert beide Wege fundiert auf Basis aktueller Best Practices, fernab von leeren Marketingversprechen oder veralteten Tutorials.

Dieser umfassende Leitfaden stellt Ihnen zwei bewährte Ansätze vor: den effizienten No-Code-Weg, der ein fertiges Modell in nur 20 Minuten für etwa 3 $ ermöglicht, sowie den technischen Pfad für die vertiefte Arbeit mit DreamBooth, LoRA und maßgeschneiderten Trainingsskripten. Sie erhalten dabei transparente Einblicke in die effektivsten Methoden und erfahren praxisnah, an welchen Stellen Herausforderungen lauern, um typische Stolpersteine sicher zu umgehen.

Schnellnavigation

Möchten Sie direkt ein individuelles Modell auf Basis Ihrer eigenen Person trainieren, um hochwertige KI-Fotos zu generieren, finden Sie in Abschnitt 3 das entsprechende Tutorial für Replicate.

Entwickler mit dem Anspruch auf maximale Kontrolle können direkt mit Abschnitt 4 zum technischen Training einsteigen.

Sollten Sie noch unschlüssig bei der Wahl der passenden Methode sein, erfahren Sie im Folgenden alles Wissenswerte für Ihre Entscheidung.

1. Was verbirgt sich eigentlich hinter dem Begriff „Modell-Training“?

Zunächst gilt es, ein verbreitetes Missverständnis zu klären: Wenn vom „Training eines KI-Bildgenerators“ die Rede ist, ist damit fast nie die Entwicklung eines Modells von Grund auf gemeint, da ein solches Vorhaben Investitionen in sechsstelliger Höhe sowie die Infrastruktur eines kompletten Rechenzentrums erfordern würde.

Im Grunde optimieren wir ein bestehendes Modell durch gezieltes Feintuning. Dabei greifen wir auf das umfangreiche Wissen von Stable Diffusion über Personen, Produkte sowie Kunststile zurück und bringen dem System anhand von lediglich 10 bis 50 Beispielbildern bei, Ihr spezifisches Motiv oder Ihren individuellen Stil präzise umzusetzen.

Einsatzbereiche und Praxisbeispiele für Ihr KI-Modell-Training

Personen & Charaktere: Durch das Training eines Modells mit lediglich 18 Fotos meiner selbst habe ich die KI darauf spezialisiert, meine individuellen Gesichtszüge präzise zu reproduzieren. Mittels des Trigger-Worts „ohw person“ lassen sich so täuschend echte Aufnahmen in den verschiedensten Kontexten generieren – vom sportlichen Surfen über professionelle Business-Porträts bis hin zu kreativen Darstellungen als Comic-Charakter.

Produkte: Viele E-Commerce-Marken setzen bereits verstärkt auf diese Technologie und generieren durch das gezielte Training mit etwa 20 Produktfotos aus verschiedenen Perspektiven beliebig viele Marketingaufnahmen in unterschiedlichsten Szenarien, was eine hocheffiziente und kostengünstige Alternative zu klassischen Fotoshootings darstellt.

Kunststile: Ein besonders spannender Aspekt ist die Möglichkeit, durch das Einlesen von etwa 30 Referenzbildern einen spezifischen Illustrationsstil zu erlernen und diesen präzise auf neue Motive zu übertragen – ein Verfahren, mit dem bereits viele Studios ihre gesamte visuelle Markenidentität konsistent skalieren.

Ein umfassender Vergleich der KI-Bildgeneratoren von Ideogram und Midjourney für das Jahr 2026 sowie eine detaillierte Analyse ihrer jeweiligen Preisstrategien.

2. Zwei Wege zur Auswahl: So finden Sie die optimale Lösung für Ihr Vorhaben

In der Praxis zeigt sich, dass für die meisten Anwender der Einstieg über No-Code-Plattformen die weitaus effizientere Wahl ist. Obwohl Entwickler verständlicherweise dazu neigen, sämtliche Prozesse in Eigenregie umzusetzen, bieten No-Code-Lösungen bereits 90 % des gewünschten Ergebnisses bei nur einem Zehntel des Aufwands – es sei denn, man benötigt zwingend maßgeschneiderte Trainingsparameter oder möchte die zugrunde liegende Technologie im Detail erforschen.

Ein umfassender Vergleich der KI-Bildgeneratoren von Ideogram und Midjourney für das Jahr 2026 sowie eine detaillierte Analyse ihrer jeweiligen Preisstrategien.

Kriterium | No-Code-Plattformen | Technischer Ansatz |

Zeitaufwand für Erstergebnisse | 15 bis 30 Minuten | 3 bis 8 Stunden (Einrichtung und Training) |

Direkte Kosten | 2 bis 10 $ pro Modell | 0 $ (lokale GPU) oder 0,50 bis 5 $ in der Cloud |

Voraussetzungen | Keinerlei Fachwissen nötig; der Foto-Upload genügt. | Python, Kommandozeile und GPU-Verständnis |

Qualitätsniveau | Hervorragend (ca. 90 % der maximalen Qualität) | Durch manuelles Finetuning potenziell steigerbar |

Ideale Anwendung | Sofortige Ergebnisse bei 1 bis 5 Modellen | Training von über 50 Modellen, Wunsch nach maximaler Kontrolle oder Fokus auf Machine Learning. |

3. Der direkte Weg: KI-Modelle effizient auf No-Code-Plattformen trainieren

Nach dem Test von fünf verschiedenen Plattformen erfahren Sie hier, welche Lösungen in der Praxis tatsächlich überzeugen.

Replicate: Der ideale Ausgangspunkt und meine persönliche Empfehlung

Die Kosten belaufen sich auf rund 2,50 $ pro Trainingseinheit sowie lediglich ca. 0,03 $ pro generiertem Bild.

Die Trainingsdauer bis zum vollständigen Abschluss beträgt etwa 18 bis 25 Minuten.

Warum fällt die Wahl ausgerechnet auf Replicate? Die Plattform überzeugt nicht nur durch ein erstklassiges Preis-Leistungs-Verhältnis, sondern auch durch eine bewusst schlichte Benutzeroberfläche, die den gesamten Prozess vom Bildupload bis zum fertigen Training denkbar einfach gestaltet. Abgerundet wird dieses nutzerfreundliche Paket durch eine außergewöhnlich gut strukturierte und lesbare Dokumentation, die in der Branche ihresgleichen sucht.

Schritt für Schritt: Der reale Prozess jenseits aller Marketing-Versprechen

Die optimale Vorbereitung Ihres Bildmaterials:

Die Erfahrung zeigt, dass bei der Erstellung individueller Datensätze die Vielfalt der Aufnahmen weitaus entscheidender ist als deren reine Anzahl. Während die Verwendung von 30 ähnlichen Porträts oft dazu führt, dass das Modell lediglich spezifische Posen starr übernimmt, erzielen bereits 18 abwechslungsreiche Fotos – durch Variation von Perspektiven, Lichtverhältnissen und Bildausschnitten – deutlich präzisere und flexiblere Ergebnisse.

Für erstklassige Ergebnisse liegt die Mindestanforderung bei 512×512 Pixeln, wobei eine Auflösung von 1024×1024 Pixeln die Detailgenauigkeit spürbar verbessert. Da die KI ausschließlich aus klar erkennbaren Vorlagen lernt, sollten Sie unbedingt auf unscharfe Fotos sowie den Einsatz von Filtern oder Beauty-Apps verzichten, damit das Modell Ihre tatsächlichen Merkmale und keine künstlich geglättete Version erfasst.

Ein umfassender Vergleich der KI-Bildgeneratoren von Ideogram und Midjourney für das Jahr 2026 sowie eine detaillierte Analyse ihrer jeweiligen Preisstrategien.

Der Upload-Prozess:

Registrieren Sie sich zunächst auf replicate.com und hinterlegen Sie Ihre Zahlungsinformationen, die auch für den kostenlosen Tarif erforderlich sind, um anschließend zum Trainingsbereich zu navigieren. Dort können Sie Bilder entweder einzeln oder – besonders effizient bei mehr als zehn Aufnahmen – als ZIP-Datei hochladen.

Der entscheidende Faktor: Das Trigger-Wort (ein unverzichtbarer Bestandteil für Ihren Erfolg):

Für ein präzises Training benötigen Sie einen einzigartigen Identifikator – beispielsweise „ohw person“ –, wobei die Wahl eines ungewöhnlichen Begriffs entscheidend ist, um Überschneidungen mit bereits im Modell vorhandenen Wörtern wie „john“ oder „photo“ zu vermeiden. Da die Plattform die Bildunterschriften auf Basis dieser Trigger-Wörter automatisch erstellt, entfällt für Sie zudem der Aufwand einer manuellen Beschriftung Ihrer Bilddaten vollständig.

Trainingseinstellungen:

Erfahrungsgemäß liefern die Standardeinstellungen von Replicate mit rund 800 Trainingsschritten für die meisten Anwendungsfälle bereits hervorragende Ergebnisse, weshalb ein Einstieg mit diesen Vorgaben ausdrücklich empfohlen wird. Sollten die Resultate jedoch die Trainingsfotos zu exakt kopieren – ein Effekt, der als Overfitting bezeichnet wird –, lässt sich die Qualität im nächsten Durchlauf meist durch eine Reduzierung auf 500 bis 600 Schritte optimieren.

Die Geduldsprobe hat ein Ende:

Das Training von 18 Bildern nimmt rund 22 Minuten in Anspruch und schließt mit einer automatischen Benachrichtigung per E-Mail ab. Da die Zeitanzeige des Fortschrittsbalkens erfahrungsgemäß recht optimistisch ausfällt, sollten Sie bei einer Restdauer von fünf Minuten eher mit der doppelten Zeit kalkulieren.

Ein umfassender Vergleich der KI-Bildgeneratoren von Ideogram und Midjourney für das Jahr 2026 sowie eine detaillierte Analyse ihrer jeweiligen Preisstrategien.

So testen Sie Ihr trainiertes Modell:

Hier beginnt der kreative Teil: Starten Sie zunächst mit einfachen Prompts wie „ein Foto einer lächelnden ohw-Person“, um Ihr Trigger-Wort zu testen, und lassen Sie bei überzeugenden Ergebnissen Ihrer Fantasie freien Lauf – ob als Superheld oder in professioneller Business-Kleidung, die Möglichkeiten für Ihr individuelles Modell sind grenzenlos.

Profi-Tipp: Optimieren Sie Ihre Ergebnisse durch den gezielten Einsatz negativer Prompts: Indem Sie Begriffe wie „unscharf, minderwertig, deformiert“ oder „verzerrt“ ausschließen, verhindern Sie effektiv unnatürliche Artefakte sowie anatomische Fehler wie überzählige Finger und erzielen so eine deutlich höhere Bildqualität.

Weitere nennenswerte Plattformen im Überblick

Im Rahmen meiner Tests haben sich diese Lösungen vor allem für spezifische Anwendungsfälle bewährt:

getimg.ai: Obwohl getimg.ai mit Kosten von etwa 8 bis 10 $ pro Modell im höheren Preissegment liegt, überzeugt die Plattform durch eine erstklassige Benutzeroberfläche sowie die Unterstützung von FLUX.1-Training. Letzteres liefert insbesondere bei komplexen Szenen deutlich überlegene Ergebnisse, was den Dienst zur idealen Wahl für den professionellen Einsatz macht.

Leonardo.Ai: Speziell auf Spieleentwickler und Concept Artists zugeschnitten, bietet Leonardo.Ai einen kostenlosen Zugang für erste Tests und überzeugt durch eine hohe Trainingsqualität, wenngleich die Benutzeroberfläche im Vergleich zu Replicate etwas komplexer gestaltet ist.

ImagineArt: Dank hocheffizienter Prozesse gelingt das Modell-Training hier in weniger als 15 Minuten, wobei die integrierte Videofunktion eine direkte Animation der erstellten Charaktere ermöglicht – ein vielversprechender Ansatz für noch dynamischere Ergebnisse.

4. Der technische Ansatz: Modell-Training mit Stable Diffusion

Sollten Sie sich für den anspruchsvolleren Weg des KI-Trainings entschieden haben, unterstützen wir diesen Ehrgeiz voll und ganz. Damit Ihnen jedoch mühsame Wochenenden voller CUDA-Fehlermeldungen erspart bleiben, haben wir hier alle entscheidenden Praxistipps gebündelt, die wir selbst gerne bereits zu Beginn unserer Arbeit mit Stable Diffusion gekannt hätten.

Warum sich der Aufwand für technisches Training lohnt

Zugegebenermaßen ist ein individuelles Modell-Training nicht für jeden Anwender zwingend erforderlich, doch gibt es durchaus entscheidende Gründe, die für diesen spezialisierten Ansatz sprechen:

Werden Dutzende oder gar Hunderte von Modellen trainiert, können die Kosten für No-Code-Lösungen schnell erheblich ins Gewicht fallen.

Für ein präzises Feintuning sind spezifische Trainingsparameter erforderlich, auf die gängige Plattformen oft keinen direkten Zugriff gewähren.

Sie arbeiten mit proprietären Daten, die Ihre geschützte Infrastruktur keinesfalls verlassen dürfen.

Vielleicht möchten Sie aber auch einfach die technologischen Hintergründe und Funktionsweisen dieser Prozesse im Detail verstehen – ein absolut legitimes Ziel.

Die drei zentralen Ansätze

DreamBooth: Diese von Google entwickelte Methode ermöglicht es, KI-Modellen neue Konzepte mithilfe eines eindeutigen Tokens sowie einer Auswahl von 5 bis 20 Bildern beizubringen. DreamBooth eignet sich hervorragend für die Darstellung spezifischer Personen oder Objekte: Während die ursprüngliche Forschungsarbeit bereits mit 3 bis 5 Referenzbildern Ergebnisse erzielte, hat sich in der Praxis ein Umfang von 15 bis 20 Bildern für eine maximale Konsistenz bewährt.

LoRA (Low Rank Adaptation): Als echter Gamechanger revolutioniert LoRA das Training, indem statt der massiven, bis zu 7 GB großen Modelldateien lediglich kompakte „Adapter“ von 3 bis 50 MB erstellt werden. Dieser hocheffiziente Ansatz beschleunigt den Prozess um das Drei- bis Fünffache und ermöglicht die Nutzung herkömmlicher Gaming-GPUs, während die Resultate qualitativ nahezu identisch mit einem vollständigen Fine-Tuning sind.

Für rund 95 % der technisch versierten Anwender stellt die Kombination aus DreamBooth und LoRA die ideale Lösung dar, da sie ein optimales Gleichgewicht zwischen Aufwand und Ergebnis bietet.

Vollständiges Modell-Feintuning: Beim Full Fine-Tuning wird das gesamte Modell trainiert, was eine beachtliche Rechenleistung von über 24 GB VRAM erfordert. In der Praxis liefert das LoRA-Verfahren jedoch bei nur einem Bruchteil des Ressourcenaufwands bereits 95 % der gewünschten Qualität, sodass sich der enorme zeitliche Aufwand eines kompletten Trainings – beispielsweise sechs Stunden auf einer A100 – im Vergleich zum Ergebnis meist kaum rentiert.

Die wichtigsten Voraussetzungen im Überblick

Hardware: Die tatsächlichen Systemanforderungen

Als Mindestvoraussetzung gilt eine NVIDIA-GPU mit 12 GB VRAM, wobei eine RTX 3060 das LoRA-Training zwar zuverlässig bewältigt, mit einer Dauer von etwa 45 Minuten jedoch vergleichsweise zeitintensiv ist. Für ein effizientes lokales Training stellen hingegen Modelle wie die RTX 4070 oder 3080 mit 16 GB VRAM die ideale Konfiguration dar.

Sollten Sie nicht über die nötige Hardware verfügen, bieten Cloud-Plattformen wie RunPod oder vast.ai kosteneffiziente Lösungen für lediglich 0,50 $ bis 2 $ pro Trainingssitzung. Alternativ ermöglicht Google Colab Pro für monatlich 10 $ einen unbegrenzten Zugriff, wobei zu Stoßzeiten mit entsprechenden Wartezeiten zu rechnen ist.

Software:

Python 3.10 oder höher (beachten Sie jedoch mögliche Kompatibilitätsprobleme bei Version 3.11).

PyTorch mit CUDA-Unterstützung

Die Diffusers-Bibliothek von Hugging Face

Optimiertes LoRA-Training durch die nahtlose Integration von Accelerate, Transformers und PEFT.

Der Trainingsprozess: Modell-Feintuning mit DreamBooth und LoRA

Da wir davon ausgehen, dass Sie mit der grundlegenden Python-Konfiguration und der Installation via pip bereits vertraut sind, überspringen wir diesen Standardprozess und konzentrieren uns stattdessen unmittelbar auf die wirklich entscheidenden Details Ihres Workflows.

Installation (mit nur einem Befehl, der garantiert reibungslos funktioniert):

pip install diffusers[torch] transformers accelerate peft bitsandbytes

Trainingsskript:

Statt Sie mit umfangreichen Code-Blöcken zu überfrachten, konzentrieren wir uns auf das Wesentliche: Wir empfehlen die Nutzung des offiziellen und kontinuierlich gewarteten Trainingsskripts aus dem Diffusers-Repository von Hugging Face, da dieses eine verlässliche Funktionalität bietet. Folgende Parameter sind dabei entscheidend:

Lernrate: Der Wert 1e-4 gilt als optimaler Richtwert, da geringere Raten wie 1e-5 das Training unnötig verlangsamen, während höhere Einstellungen um 5e-4 die Stabilität des Modells gefährden.

Trainingsschritte: In den meisten Fällen empfiehlt sich ein Umfang von 800 bis 1000 Schritten, da eine geringere Anzahl den Lernerfolg beeinträchtigt, während bei einer höheren Anzahl das Risiko eines Overfittings besteht.

Batch-Größe: 1 oder 2, da die Hardware-Anforderungen beim LoRA-Training die Kapazität gängiger Grafikprozessoren bei höheren Werten meist übersteigen.

LoRA-Rank: Die Wahl zwischen 16 oder 32 beeinflusst das Verhältnis von Kapazität zu Geschwindigkeit, wobei sich ein Rank von 16 hervorragend für Gesichter eignet, während für anspruchsvollere Kunststile ein Wert von 32 die besten Ergebnisse liefert.

Ein umfassender Vergleich der KI-Bildgeneratoren von Ideogram und Midjourney für das Jahr 2026 sowie eine detaillierte Analyse ihrer jeweiligen Preisstrategien.

Beispiel für den tatsächlich ausgeführten Befehl:

accelerate launch train_dreambooth_lora_sdxl.py \

vortrainierter_modellname_oder_pfad="stabilityai/stable diffusion xl base 1.0" \

instance_data_dir="./meine_trainingsbilder" \

instance_prompt="Ein Foto der sks-Person" \

Auflösung=1024 \

train_batch_size=1 \

Lernrate=1e-4 \

max_train_steps=800 \

LoRA-Integration nutzen \

lora_r=16 \

output_dir="./output_lora"

Während die Rechenzeit auf einer RTX 3060 etwa 38 Minuten betrug, lässt sie sich mit einer RTX 4090 auf unter 15 Minuten reduzieren, wogegen bei der Nutzung der kostenlosen T4-Instanz von Google Colab mit einer Dauer von über 90 Minuten zu rechnen ist.

5. Die Datensatz-Vorbereitung: Der entscheidende Faktor für erstklassige Ergebnisse

Da dieser essenzielle Punkt in den meisten Anleitungen oft vernachlässigt wird, steht er hier bewusst an zentraler Stelle: Die Qualität Ihres KI-Trainings wird zu 80 % von der Beschaffenheit Ihres Datensatzes bestimmt, während die technischen Einstellungen lediglich die restlichen 20 % ausmachen.

Die entscheidenden Regeln aus der Praxis

Die ideale Bildmenge für optimale Ergebnisse liegt zwischen 15 und 25 Aufnahmen. Während häufig empfohlene 5 bis 10 Bilder meist nur für sehr einfache Motive ausreichen, erzielen Datensätze von über 40 Bildern keinen qualitativen Mehrwert, sondern verlängern lediglich die Rechenzeit ohne spürbare Verbesserung.

Die optimale Auflösung ist entscheidend: Während für Stable Diffusion 1.5 mindestens 512×512 Pixel erforderlich sind, setzt SDXL eine Basis von 1024×1024 Pixeln voraus. Verzichten Sie darauf, hochauflösende Smartphone-Fotos im Originalformat zu verwenden, da dies die Trainingseffizienz mindert – skalieren Sie Ihre Bilder stattdessen vorab auf das empfohlene Maß.

Vielfalt vor Quantität: Man kann es nicht oft genug betonen – 15 abwechslungsreiche Bilder erzielen weitaus bessere Ergebnisse als 30 monotone Aufnahmen. Setzen Sie gezielt auf unterschiedliche Blickwinkel, Lichtverhältnisse und Kontexte. Beim Training einer Person sollten zudem Nahaufnahmen und Ganzkörperbilder mit variierenden Gesichtsausdrücken sowie unterschiedlicher Kleidung kombiniert werden.

Typische Fehler bei der Datensatzerstellung – Einblick in häufige Stolperfallen aus der Praxis

Verwendung gefilterter oder bearbeiteter Aufnahmen: Verzichten Sie konsequent auf Instagram-Filter, den Beauty-Modus sowie starke Bildbearbeitungen, da das Modell andernfalls lediglich die Filtercharakteristiken anstatt des eigentlichen Motivs übernimmt.

Inkonsistente Beleuchtung: Eine gewisse Varianz ist zwar vorteilhaft, doch führen zu starke Kontraste – etwa zwischen hellem Tageslicht und schummriger Club-Atmosphäre – zu Inkonsistenzen, die die Präzision des Modells beeinträchtigen.

Mehrere Personen im Bild: Um eine präzise Modellierung der eigenen Person zu gewährleisten, sollten Sie andere Menschen konsequent aus Ihren Trainingsbildern herausschneiden, da das Modell sonst Gefahr läuft, visuelle Merkmale zu vermischen. Praxistests zeigen, dass bereits wenige Aufnahmen mit fremden Personen dazu führen können, dass das KI-Modell fälschlicherweise deren Attribute – wie etwa die Frisur – auf das generierte Bild überträgt.

Wasserzeichen und Texte: Da das Modell solche Elemente ebenfalls erlernt, sollten diese vorab konsequent entfernt oder durch präzises Zuschneiden eliminiert werden.

Ein umfassender Vergleich der KI-Bildgeneratoren von Ideogram und Midjourney für das Jahr 2026 sowie eine detaillierte Analyse ihrer jeweiligen Preisstrategien.

6. Die tatsächliche Kostenaufschlüsselung

Kommen wir zum finanziellen Aspekt: Hier finden Sie eine transparente Aufschlüsselung der tatsächlichen Kosten, die im Rahmen dieser Testreihe angefallen sind.

Ein umfassender Vergleich der KI-Bildgeneratoren von Ideogram und Midjourney für das Jahr 2026 sowie eine detaillierte Analyse ihrer jeweiligen Preisstrategien.

Service-Anbieter | Trainingskosten | Kosten pro Bild | Einschätzung |

Replicate | 2,47 $ | 0,028 $ | Bestes Preis-Leistungs-Verhältnis |

getimg.ai | 8,00 $ | 0,05 $ bis 0,08 $ | Besonders lohnenswert für FLUX-Modelle |

Leonardo.Ai | Kostenlos bis ca. 10 $ | Variabel | Ideal für erste Testläufe |

Google Colab Pro | 10 $/Monat (unlimitiert) | 0 $ | Wirtschaftlich ab ca. 10 Modellen |

RunPod (RTX 3090) | ca. 0,80 $ | 0 $ (Self-hosted) | Die optimale Wahl für Entwickler |

Lokale GPU | ca. 0,15 $ Stromkosten | 0 $ | Empfehlenswert bei vorhandener Hardware |

7. Fehlerbehebung: Strategien für den souveränen Umgang mit typischen Herausforderungen

Profitieren Sie von meinen Praxiserfahrungen: Im Folgenden erläutere ich die gängigsten Herausforderungen sowie deren effiziente Lösungen, damit Sie typische Fehler vermeiden und direkt zum Ziel gelangen.

Problem: Das Modell reproduziert lediglich die Trainingsfotos, statt neue Bildinhalte zu generieren

Dieses als Overfitting bezeichnete Phänomen führt dazu, dass bei einer Eingabe wie „sks person at the beach“ lediglich das ursprüngliche Trainingsfoto vor einer Strandkulisse reproduziert wird.

Was sich in der Praxis bewährt hat:

Eine Reduzierung der Trainingsschritte von 1000 auf 600 führte zu einer sofortigen Qualitätssteigerung, da das Modell fortan generalisierte, statt lediglich Muster auswendig zu lernen; flankiert wurde dieser Prozess durch ein vielseitigeres Trainingsset, was die Präzision zusätzlich erhöhte.

Die Herausforderung: Inkonsistente Gesichter und Bildstile

Die Resultate schwanken oft zwischen beeindruckender Perfektion und einer kaum erkennbaren Ähnlichkeit zum ursprünglichen Trainingsmotiv.

Was sich in der Praxis bewährt hat:

Erzielen Sie präzisere Ergebnisse durch eine verlängerte Trainingsdauer, etwa durch eine Steigerung von 600 auf 900 Schritte. Achten Sie dabei stets darauf, Ihr spezifisches Trigger-Wort – beispielsweise „sks person“ statt lediglich „person“ – konsequent in den Prompt zu integrieren und den Guidance Scale (CFG) während der Generierung auf einen Wert zwischen 8 und 10 anzuheben.

Die Herausforderung: „CUDA Out of Memory“

Dieser Abschnitt richtet sich gezielt an Fachleute, deren Grafikkarte bereits an die Kapazitätsgrenzen des verfügbaren VRAM gestoßen ist.

Schnelle Lösungen:

Setzen Sie die Batch-Größe auf 1 und aktivieren Sie sowohl das Gradient Checkpointing ( gradient_checkpointing) als auch Mixed Precision ( mixed_precision="fp16"). Sollten dennoch Probleme auftreten, reduzieren Sie die Auflösung von 1024 auf 768 oder nutzen Sie als letzte Option use_8bit_adam.

Herausforderung: Unverhältnismäßig lange Trainingszeiten

Mein erster Trainingslauf auf einer 3060 nahm zwei Stunden in Anspruch und war damit weitaus zu zeitintensiv.

Was zum Erfolg beigetragen hat:

Setzen Sie auf LoRA statt auf ein vollständiges Fine-Tuning, um die Trainingszeit um das Fünffache zu verkürzen. Für Testläufe empfiehlt sich zudem eine reduzierte Auflösung von 512 px sowie eine Begrenzung auf 800 Schritte, was in den meisten Fällen völlig ausreicht. Alternativ investieren Sie lediglich 0,80 $ für 30 Minuten Rechenpower auf einer RTX 4090 via RunPod – denn Zeit ist schließlich bares Geld.

8. FLUX.1 im Fokus: Das neue Modell im Überblick

FLUX.1 wurde Mitte 2024 von Black Forest Labs veröffentlicht – einem Team aus Gründungsmitgliedern von Stable Diffusion – und übertrifft SDXL in den meisten Anwendungsszenarien deutlich, insbesondere in den folgenden Bereichen:

Präzise Umsetzung selbst komplexester Prompts

Die Erstellung von präzisem, lesbarem Text in Bildern – ein Bereich, in dem Standardmodelle wie SDXL oft unzureichende Ergebnisse liefern.

Die Qualität des Fotorealismus wurde spürbar optimiert.

Vermeiden Sie störende Bildartefakte und sorgen Sie für anatomisch korrekte Ergebnisse mit deutlich weniger Darstellungsfehlern.

Zu beachten ist jedoch, dass das Training kostenintensiver ist und eine hohe VRAM-Kapazität von mindestens 20 GB voraussetzt. Während Anbieter wie getimg.ai FLUX-Trainings für etwa 10 bis 12 US-Dollar pro Modell ermöglichen und auch Replicate sein Portfolio entsprechend erweitert hat, erfordert die lokale Durchführung leistungsstarke Hardware wie eine RTX 4090 oder das Anmieten spezialisierter Cloud-Ressourcen.

Lohnt sich der Aufwand? Während SDXL für private Projekte oder Testzwecke weiterhin hervorragende Ergebnisse liefert, ist das gezielte Training für professionelle Anwendungen mit höchstem Qualitätsanspruch absolut empfehlenswert.

Abschließendes Fazit

Was vor knapp zwei Jahren noch spezialisierten Forschungslaboren vorbehalten war, hat sich mittlerweile zu einem effizient umsetzbaren Projekt entwickelt, wodurch das Training individueller KI-Bildgeneratoren heute für jeden Anwender beeindruckend zugänglich ist.

Hier ist meine konkrete Empfehlung für den optimalen Workflow:

Beginnen Sie Ihren Einstieg am besten mit Replicate, um zunächst ein einzelnes Modell zu trainieren und dessen Eignung für Ihre spezifischen Anforderungen zu prüfen. Während dieser einfache Weg oft bereits zum gewünschten Ziel führt, bietet die technische Route die nötige Flexibilität für eine präzisere Kontrolle oder die Skalierung auf zahlreiche Modelle. Machen Sie es sich nicht zu kompliziert: Schon 15 Fotos und ein Budget von 3 Dollar genügen für den direkten Start.

Da sich die Technologie rasant weiterentwickelt und FLUX.1 bereits heute SDXL übertrifft, während in wenigen Monaten schon die nächste Innovation folgen wird, sollten Sie nicht auf das vermeintlich „perfekte“ Modell warten, sondern das Potenzial der aktuell verfügbaren Lösungen direkt ausschöpfen.

Viel Erfolg – und denken Sie daran, dass das erste Modell selten perfekt ist. Da auch meine ersten Versuche nicht makellos waren, ist dies völlig normal, denn die wertvollsten Erkenntnisse gewinnen Sie ohnehin erst durch die praktische Anwendung.

Entdecken Sie die 11 besten Ideogram-Alternativen des Jahres 2026 und erhalten Sie einen umfassenden Überblick über modernste KI-Bildgenerierung, attraktive Preismodelle sowie vielfältige künstlerische Stile.

Entdecken Sie die 11 besten Ideogram-Alternativen des Jahres 2026 und erhalten Sie einen umfassenden Überblick über modernste KI-Bildgenerierung, attraktive Preismodelle sowie vielfältige künstlerische Stile.

Ein umfassender Vergleich der KI-Bildgeneratoren von Ideogram und Midjourney für das Jahr 2026 sowie eine detaillierte Analyse ihrer jeweiligen Preisstrategien.