Cómo entrenar un generador de imágenes con IA: Guía completa para 2026

Última actualización: 2026-01-22 18:08:26

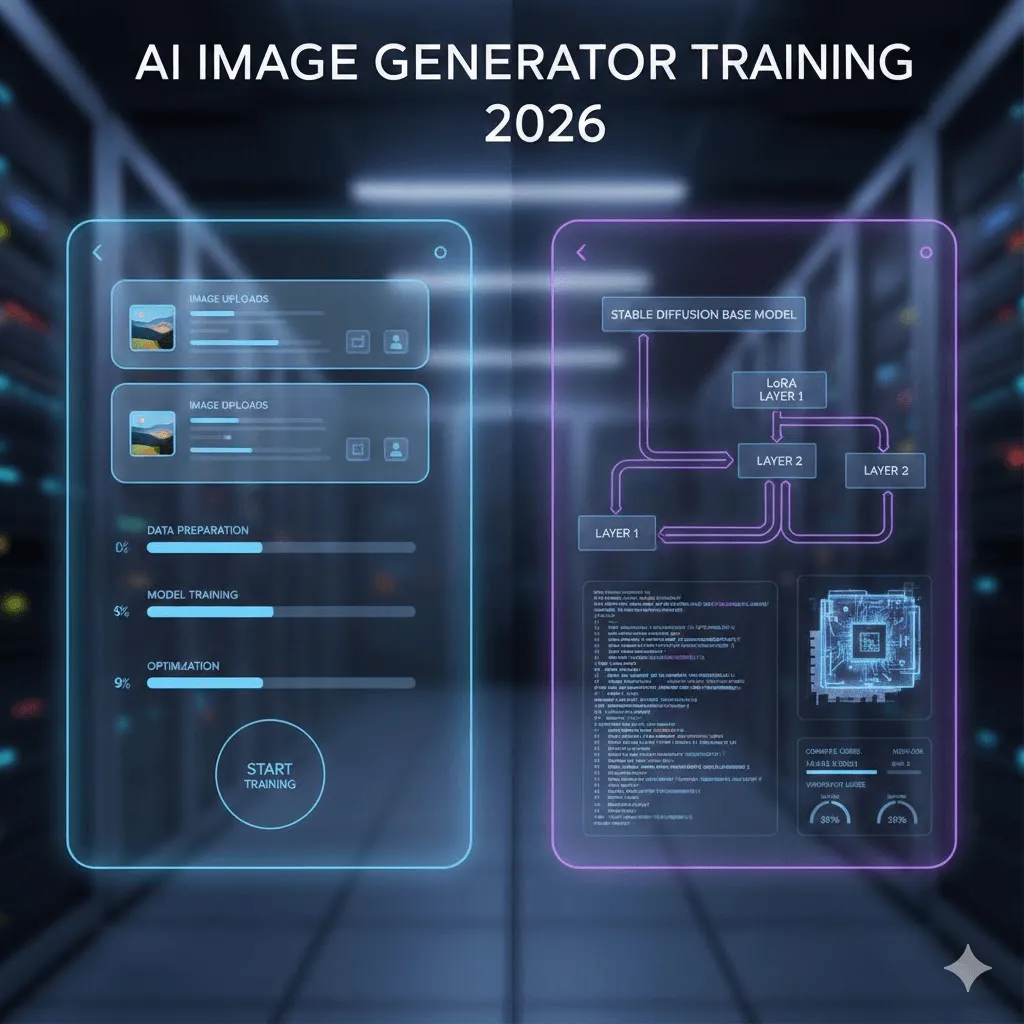

En 2026, el entrenamiento de generadores de imágenes por inteligencia artificial ha dejado de ser una disciplina reservada a la investigación técnica para convertirse en una habilidad accesible. Aquellos procesos que antes exigían profundos conocimientos de aprendizaje automático, infraestructuras costosas y semanas de experimentación, hoy pueden completarse en menos de una hora —e incluso en apenas 20 minutos— siempre que se elija la metodología adecuada.

Cabe destacar que no todos los procesos de entrenamiento de IA son iguales: mientras que algunos métodos resultan rápidos y económicos pero presentan limitaciones, otros ofrecen un control total a cambio de una mayor complejidad técnica. Esta guía analiza ambas alternativas con claridad, basándose en soluciones actuales y eficaces que van más allá de simples promesas comerciales o tutoriales obsoletos.

Esta guía explora detalladamente ambas metodologías: desde la vía sin código, que permite entrenar modelos en apenas 20 minutos con una inversión aproximada de 3 dólares, hasta el enfoque técnico diseñado para quienes buscan profundizar en DreamBooth, LoRA y scripts personalizados. A través de una perspectiva honesta basada en mi propia experiencia, analizaremos qué estrategias ofrecen resultados reales y cuáles son los obstáculos comunes donde podrías encontrar dificultades.

Navegación rápida

Si su objetivo principal es entrenar un modelo con su propia imagen para generar fotografías mediante IA, le recomendamos dirigirse directamente a la sección 3, donde encontrará el tutorial detallado sobre Replicate.

Para aquellos desarrolladores que busquen un control total sobre el proceso, recomendamos dirigirse directamente a la Sección 4 para iniciar el entrenamiento técnico.

Si aún no tiene claro qué enfoque elegir, continúe leyendo para profundizar en los detalles a continuación.

1. ¿En qué consiste realmente el proceso de entrenamiento?

Para despejar cualquier duda inicial, es importante aclarar que, al hablar de "entrenar un generador de imágenes de IA", casi nunca nos referimos a la creación de un modelo desde cero, un proceso que exigiría una infraestructura de datos masiva e inversiones de cientos de miles de dólares.

En esencia, el proceso consiste en realizar un ajuste fino sobre un modelo ya existente; aprovechando que Stable Diffusion ya domina la representación de personas, productos y estilos, su labor será enseñarle a reconocer su sujeto o estética particular mediante una muestra de entre 10 y 50 imágenes de ejemplo.

Posibilidades de entrenamiento: ejemplos reales

Personas y personajes: Al entrenar un modelo con apenas 18 fotografías propias, el sistema logra asimilar cada rasgo facial para permitir la creación de imágenes personalizadas en cualquier contexto —ya sea practicando surf, vistiendo un traje formal o transformado en un personaje animado—, activándose fácilmente mediante el uso de la palabra clave "ohw person".

Productos: Esta solución, ampliamente adoptada por el sector del comercio electrónico, permite generar un catálogo ilimitado de imágenes publicitarias en cualquier entorno tras entrenar el modelo con apenas 20 fotografías desde diversos ángulos, optimizando significativamente los costes frente a las sesiones fotográficas tradicionales.

Estilos artísticos: Esta fascinante opción permite replicar cualquier estilo de ilustración en nuevos conceptos con tan solo 30 imágenes de referencia; una solución que ya emplean diversos estudios para unificar y automatizar toda su identidad visual.

Descubra nuestra comparativa exhaustiva de 2026 sobre Ideogram y Midjourney, analizando a fondo el potencial de estos generadores de imágenes IA y sus diversas estrategias de precios. Evaluamos cómo estas herramientas de diseño gráfico lideran la creación de contenido visual y el arte generado por IA, ofreciendo soluciones de diseño inteligente que abarcan desde la conversión de texto a imagen hasta la tipografía avanzada para optimizar sus proyectos profesionales.

2. Dos alternativas de implementación: elija la opción que mejor se adapte a sus necesidades

La realidad es clara: para la mayoría de los usuarios, el punto de partida ideal son las plataformas sin código. Si bien existe una tendencia natural a preferir el enfoque manual, este solo se justifica si se requieren parámetros de entrenamiento específicos o un dominio técnico profundo; de lo contrario, la vía «no-code» permite alcanzar el 90% de los resultados con apenas una fracción del esfuerzo.

Descubra nuestra comparativa exhaustiva de 2026 sobre Ideogram y Midjourney, analizando a fondo el potencial de estos generadores de imágenes IA y sus diversas estrategias de precios. Evaluamos cómo estas herramientas de diseño gráfico lideran la creación de contenido visual y el arte generado por IA, ofreciendo soluciones de diseño inteligente que abarcan desde la conversión de texto a imagen hasta la tipografía avanzada para optimizar sus proyectos profesionales.

Factor clave | Plataformas No-Code | Enfoque técnico |

Tiempo para obtener resultados | De 15 a 30 minutos | Entre 3 y 8 horas (configuración y entrenamiento) |

Inversión inicial | Entre 2 y 10 USD por modelo | Sin coste (GPU local) o de 0,50 a 5 USD (nube) |

Requisitos de conocimiento | Ninguno; el proceso consiste simplemente en subir sus fotos. | Manejo de Python, línea de comandos y arquitectura GPU. |

Potencial de calidad | Nivel profesional (cercano al 90%). | Superior, mediante el ajuste fino de parámetros. |

Escenario ideal de uso | Necesidad de resultados inmediatos para entrenar de 1 a 5 modelos. | Entrenamiento masivo (+50 modelos), control absoluto o aprendizaje de ML. |

3. La vía rápida: Entrenamiento mediante plataformas sin código

Tras evaluar exhaustivamente cinco plataformas distintas, presentamos las soluciones que realmente han demostrado su eficacia.

Replicate: el punto de partida ideal y nuestra opción recomendada

El coste por sesión de entrenamiento es de aproximadamente 2,50 $, lo que permite obtener cada imagen generada por una inversión de apenas 0,03 $.

El entrenamiento se completa en un periodo de entre 18 y 25 minutos.

¿Por qué elegir Replicate específicamente? Destaca por ofrecer la mejor relación calidad-precio del mercado mediante una interfaz intuitiva y directa que elimina cualquier complejidad innecesaria. El flujo de trabajo es tan sencillo como subir las imágenes y dejar que el modelo se entrene, todo ello respaldado por una documentación excepcionalmente clara y accesible.

Guía detallada: el proceso auténtico paso a paso, lejos de las promesas del marketing

Preparación y optimización de sus imágenes:

Tras realizar pruebas con 18 fotografías propias, la lección fundamental es que la diversidad de las imágenes resulta mucho más determinante que la cantidad total. Mientras que un primer intento con 30 retratos similares provocó que el modelo se limitara a memorizar poses específicas, una segunda iteración con 18 tomas variadas —que incluían distintos ángulos, condiciones de iluminación y planos de cuerpo completo— ofreció resultados notablemente superiores.

Para obtener resultados óptimos, se requiere una resolución mínima de 512×512 píxeles, aunque el uso de imágenes de 1024×1024 mejora notablemente la precisión del modelo. Es fundamental prescindir de fotografías borrosas, ya que la IA requiere de una nitidez absoluta para procesar la información, así como evitar el uso de filtros intensos o aplicaciones de retoque automatizado; el objetivo es que el modelo capture sus rasgos reales con total fidelidad en lugar de generar una versión artificialmente suavizada.

Descubra nuestra comparativa exhaustiva de 2026 sobre Ideogram y Midjourney, analizando a fondo el potencial de estos generadores de imágenes IA y sus diversas estrategias de precios. Evaluamos cómo estas herramientas de diseño gráfico lideran la creación de contenido visual y el arte generado por IA, ofreciendo soluciones de diseño inteligente que abarcan desde la conversión de texto a imagen hasta la tipografía avanzada para optimizar sus proyectos profesionales.

El proceso de carga de archivos:

Acceda a replicate.com para completar su registro, teniendo en cuenta que el sistema requiere introducir información de pago incluso para el nivel gratuito. Una vez dentro, diríjase a la sección de entrenamiento para cargar sus imágenes de forma individual o mediante un archivo ZIP, siendo esta última opción la más eficiente y recomendable cuando se trabaje con lotes de más de diez archivos.

La palabra de activación (un factor fundamental):

Para obtener resultados óptimos, es fundamental seleccionar un identificador único y poco común —como "ohw person"— evitando términos genéricos como "john" o "foto" que ya forman parte del entrenamiento base del modelo. Al emplear estos activadores específicos, la plataforma genera automáticamente las descripciones de las imágenes, simplificando el proceso al eliminar por completo la necesidad de realizar un etiquetado manual.

Configuración del entrenamiento:

En la práctica, lo más recomendable es mantener los valores predeterminados de Replicate, que establece unos 800 pasos de entrenamiento para cubrir la mayoría de las necesidades. Aunque es posible ajustar este parámetro, conviene comenzar con la configuración estándar; si detecta que los resultados replican con demasiada exactitud las imágenes originales —fenómeno conocido como sobreajuste o overfitting—, le sugerimos reducir la cifra a unos 500 o 600 pasos en su siguiente sesión.

La fase de espera:

Tras completar el entrenamiento de las 18 imágenes en apenas 22 minutos, recibirá una notificación automática por correo electrónico; no obstante, considere que la barra de progreso suele ser optimista, por lo que una estimación de cinco minutos restantes puede traducirse, en la práctica, en diez minutos reales de procesamiento.

Descubra nuestra comparativa exhaustiva de 2026 sobre Ideogram y Midjourney, analizando a fondo el potencial de estos generadores de imágenes IA y sus diversas estrategias de precios. Evaluamos cómo estas herramientas de diseño gráfico lideran la creación de contenido visual y el arte generado por IA, ofreciendo soluciones de diseño inteligente que abarcan desde la conversión de texto a imagen hasta la tipografía avanzada para optimizar sus proyectos profesionales.

Pruebe y valide su modelo:

Aquí comienza la fase más creativa: inicie el proceso con una descripción sencilla como «una foto de la persona ohw sonriendo» y, tras verificar los resultados, explore nuevas posibilidades transformando al sujeto en un superhéroe o generando un retrato profesional con atuendo ejecutivo.

Un consejo profesional para elevar la calidad de sus creaciones es el uso estratégico de prompts negativos; al incluir términos como «borroso, baja calidad, deformado o distorsionado», podrá optimizar drásticamente los resultados y prevenir la aparición de artefactos visuales o errores anatómicos que el modelo suele generar de forma involuntaria.

Otras plataformas de interés que merece la pena conocer

Tras evaluar estas alternativas, consideramos que su aplicación resulta más efectiva en casos de uso específicos:

getimg.ai: Aunque presenta un coste superior —entre 8 y 10 $ por modelo—, compensa esta inversión con una interfaz excepcional y compatibilidad con el entrenamiento de FLUX.1, lo que garantiza resultados notablemente superiores en escenas complejas y lo convierte en la opción ideal para el ámbito profesional.

Leonardo.Ai: Especialmente orientada a desarrolladores de videojuegos y artistas conceptuales, esta plataforma dispone de un plan gratuito para realizar pruebas y destaca por la solidez de sus entrenamientos, aunque su interfaz sea algo más compleja que la de Replicate.

ImagineArt: Con un proceso de entrenamiento ágil que se completa en menos de 15 minutos, esta plataforma ha integrado funciones de generación de vídeo para animar personajes personalizados; aunque aún requiere pruebas exhaustivas, su potencial resulta sumamente prometedor.

4. El enfoque técnico: entrenamiento y optimización con Stable Diffusion

Si ha decidido optar por la vía técnica y asumir el reto, valoramos su determinación; por ello, hemos recopilado toda la información esencial que nos habría ahorrado incontables horas de resolución de errores de CUDA antes de comenzar.

¿Por qué es fundamental el entrenamiento técnico de modelos?

Siendo realistas, aunque la mayoría de los usuarios no requerirá este nivel de personalización, existen motivos legítimos y casos de uso específicos que justifican su implementación:

Si entrena decenas o cientos de modelos, los costes de las plataformas sin código pueden empezar a acumularse rápidamente.

Es indispensable contar con parámetros de entrenamiento específicos que las plataformas convencionales no suelen poner a disposición del usuario.

Gestione datos confidenciales y de propiedad exclusiva con la total seguridad de que estos nunca abandonarán su propia infraestructura.

Comprender a fondo los mecanismos que rigen esta tecnología es una motivación tan legítima como fundamental.

Los tres enfoques principales

DreamBooth: Este método desarrollado por Google permite enseñar al modelo nuevos conceptos específicos mediante un identificador exclusivo y un conjunto de entre 5 y 20 imágenes, resultando especialmente eficaz para la recreación de personas y objetos. Aunque la documentación original demuestra su viabilidad con apenas 3 a 5 imágenes de referencia, el uso de 15 a 20 fotografías en entornos prácticos suele proporcionar una consistencia y fidelidad visual superiores.

LoRA (Low Rank Adaptation): Esta tecnología representa una auténtica revolución, ya que permite generar un ligero archivo «adaptador» de apenas 3-50 MB en lugar de modificar los archivos masivos del modelo original, que suelen alcanzar los 5-7 GB. Gracias a este enfoque, el proceso de entrenamiento es de 3 a 5 veces más rápido y puede ejecutarse en GPUs convencionales, garantizando una calidad de resultados prácticamente idéntica a la del ajuste fino completo.

Esta es la opción recomendada para el 95 % de los usuarios técnicos, ya que la combinación de DreamBooth y LoRA ofrece el equilibrio perfecto entre rendimiento y calidad.

Ajuste fino completo: Este método consiste en entrenar la totalidad del modelo, un proceso que exige hardware de alta gama con al menos 24 GB de VRAM; no obstante, la técnica LoRA suele ser preferible al ofrecer una precisión equivalente con apenas una fracción de los recursos, puesto que incluso tras sesiones de seis horas en una GPU A100, los resultados finales no muestran una mejora significativa frente a la eficiencia de LoRA.

Lo que realmente necesita

Hardware: especificaciones técnicas y requisitos reales

El requisito mínimo para este proceso es una GPU NVIDIA con 12 GB de VRAM; si bien una RTX 3060 de 12 GB es funcional para el entrenamiento LoRA en unos 45 minutos, el punto de equilibrio óptimo para el entrenamiento local se sitúa en modelos como la RTX 4070 o la 3080 de 16 GB.

Si no cuenta con una GPU propia, existen alternativas en la nube como RunPod o vast.ai con costes de entre 0,50 y 2 USD por sesión; asimismo, Google Colab Pro ofrece acceso ilimitado por 10 USD al mes, si bien los tiempos de espera pueden aumentar durante los periodos de máxima demanda.

Software:

Se recomienda el uso de Python 3.10 o versiones posteriores, ya que la versión 3.11 podría presentar ciertos problemas de compatibilidad.

PyTorch con soporte para CUDA

La biblioteca diffusers de Hugging Face

Optimice sus procesos mediante las librerías accelerate y transformers, integrando la potencia de peft para la implementación de LoRA.

Metodología y ejecución del proceso de entrenamiento (DreamBooth y LoRA)

Prescindiremos de la configuración inicial del entorno de Python, asumiendo que el lector ya posee los conocimientos necesarios para gestionar librerías mediante pip, y nos enfocaremos directamente en los pilares fundamentales que marcan la diferencia en el proceso.

Instalación simplificada: el comando de una sola línea que realmente funciona:

p>pip install diffusers[torch] transformers accelerate peft bitsandbytesGuion de entrenamiento:

Para evitar el uso de extensos bloques de código, le presentamos los puntos fundamentales: le recomendamos utilizar el script de entrenamiento oficial del repositorio "diffusers" de Hugging Face, una solución plenamente operativa y en constante mantenimiento que cuenta con los siguientes parámetros clave:

Tasa de aprendizaje: Tras evaluar distintas configuraciones, se determinó que 1e~4 es el valor óptimo, ya que una tasa de 1e~5 ralentiza el proceso en exceso y una de 5e~4 compromete la estabilidad del modelo; por ello, se recomienda mantener este ajuste en 1e~4.

Pasos de entrenamiento: se recomienda configurar entre 800 y 1000 para la mayoría de los casos, garantizando así un aprendizaje suficiente sin incurrir en riesgos de sobreajuste por un exceso de iteraciones.

Tamaño de lote: Se recomienda un valor de 1 o 2, ya que las limitaciones de memoria de la GPU suelen impedir el procesamiento de cargas mayores al trabajar con LoRA.

Rango LoRA: Se recomienda un valor de 16 o 32; si bien un rango superior ofrece mayor capacidad, también ralentiza el proceso. Mientras que el ajuste de 16 es suficiente para rostros, el valor de 32 resulta ideal para capturar estilos artísticos complejos.

Descubra nuestra comparativa exhaustiva de 2026 sobre Ideogram y Midjourney, analizando a fondo el potencial de estos generadores de imágenes IA y sus diversas estrategias de precios. Evaluamos cómo estas herramientas de diseño gráfico lideran la creación de contenido visual y el arte generado por IA, ofreciendo soluciones de diseño inteligente que abarcan desde la conversión de texto a imagen hasta la tipografía avanzada para optimizar sus proyectos profesionales.

Ejemplo del comando utilizado en la ejecución real:

accelerate launch train_dreambooth_lora_sdxl.py \

pretrained_model_name_or_path="stabilityai/stable diffusion xl base 1.0" \

instance_data_dir="./mis_imagenes_de_entrenamiento" \

instance_prompt="una fotografía de la persona sks" \

resolución=1024 \

train_batch_size=1 \

tasa de aprendizaje = 1e 4 \

max_train_steps=800 \

use_lora \

lora_r=16 \

directorio_de_salida="./salida_lora"

Este proceso se completó en 38 minutos con una RTX 3060, una tarea que apenas requeriría 15 minutos en una 4090, pero que en la T4 gratuita de Google Colab se extendería más allá de los 90 minutos.

5. Preparación del dataset: el factor determinante de la calidad final

Iniciamos con este apartado fundamental puesto que, a diferencia de otros manuales que suelen omitirlo, el éxito del entrenamiento reside en un 80 % en la calidad del conjunto de datos, frente a un 20 % que depende de la configuración elegida.

Principios fundamentales: Lecciones aprendidas mediante el ensayo y error

La cantidad óptima se sitúa entre las 15 y 25 imágenes. Si bien algunos recomiendan utilizar solo entre 5 y 10, esta cifra suele ser insuficiente a menos que el sujeto sea sumamente sencillo; por el contrario, exceder las 40 imágenes no aporta una mejora real y solo sirve para prolongar innecesariamente el tiempo de entrenamiento.

La resolución es un factor determinante: se requiere un mínimo de 512×512 para SD 1.5 y 1024×1024 para SDXL, por lo que es fundamental ajustar el tamaño de las fotos móviles de alta resolución antes de procesarlas para garantizar la máxima eficiencia en el entrenamiento.

La variedad es superior a la cantidad: No se puede subestimar la importancia de este principio, ya que 15 imágenes diversas resultan mucho más efectivas que 30 tomas similares. Para optimizar el entrenamiento, integre una amplia gama de ángulos, condiciones de iluminación y contextos; por ejemplo, si el modelo se basa en una persona, incluya desde primeros planos hasta tomas de cuerpo completo, variando tanto las expresiones faciales como la vestimenta.

Errores habituales en la preparación de datasets: lecciones aprendidas de mi propia experiencia

Uso de imágenes filtradas o editadas: Evite el empleo de filtros de Instagram, modos de belleza o retoques excesivos, ya que el modelo asimilará estos efectos en lugar de capturar las características reales del sujeto.

Iluminación inconsistente: Si bien un ligero margen de variación es positivo, alternar drásticamente entre luz diurna y entornos nocturnos o tenues tiende a confundir al modelo durante el aprendizaje.

Presencia de varias personas en el encuadre: Al entrenar el modelo con su propia imagen, es fundamental recortar a los demás sujetos para evitar que la IA combine rasgos no deseados; de lo contrario, el sistema podría asimilar características ajenas, tal como ocurrió en una de nuestras pruebas donde el modelo replicó el peinado de un tercero presente en tan solo tres fotografías.

Marcas de agua y texto: Es fundamental eliminar estos elementos o recortar las imágenes originales, ya que el modelo los integrará como parte del aprendizaje.

Descubra nuestra comparativa exhaustiva de 2026 sobre Ideogram y Midjourney, analizando a fondo el potencial de estos generadores de imágenes IA y sus diversas estrategias de precios. Evaluamos cómo estas herramientas de diseño gráfico lideran la creación de contenido visual y el arte generado por IA, ofreciendo soluciones de diseño inteligente que abarcan desde la conversión de texto a imagen hasta la tipografía avanzada para optimizar sus proyectos profesionales.

6. Desglose detallado de los costes reales

Hablemos de inversión: a continuación, detallo el desglose real de los costes derivados de las pruebas realizadas para esta guía.

Descubra nuestra comparativa exhaustiva de 2026 sobre Ideogram y Midjourney, analizando a fondo el potencial de estos generadores de imágenes IA y sus diversas estrategias de precios. Evaluamos cómo estas herramientas de diseño gráfico lideran la creación de contenido visual y el arte generado por IA, ofreciendo soluciones de diseño inteligente que abarcan desde la conversión de texto a imagen hasta la tipografía avanzada para optimizar sus proyectos profesionales.

Servicio | Coste de entrenamiento | Por imagen | Valoración experta |

Replicate | $2,47 | $0,028 | La mejor relación calidad-precio |

getimg.ai | $8,00 | $0,05~0,08 | Una inversión que merece la pena para FLUX |

Leonardo.Ai | Gratis a $10 | Variable | Recomendado para fases de prueba |

Google Colab Pro | $10/mes (ilimitado) | $0 | Rentable al crear más de 10 modelos |

RunPod (RTX 3090) | ~$0,80 | $0 (autohospedado) | El punto óptimo para desarrolladores |

GPU Local | ~$0,15 (electricidad) | $0 | La opción ideal si ya cuenta con el hardware necesario. |

7. Resolución de problemas: Guía para solventar los errores más frecuentes

He recopilado los desafíos reales encontrados y sus respectivas soluciones con el fin de facilitarle el proceso y evitarle contratiempos innecesarios.

El problema del sobreajuste: cuando el modelo se limita a replicar fielmente las imágenes de entrenamiento

Este fenómeno, conocido como sobreajuste o overfitting, ocurre cuando el modelo se limita a replicar casi exactamente la imagen de entrenamiento original al procesar un comando como «sks person at the beach», integrándola de forma literal en el nuevo escenario.

Estrategias con resultados comprobados:

Al optimizar el proceso reduciendo los pasos de entrenamiento de 1000 a 600, se logra una mejora inmediata: el modelo deja de memorizar para empezar a generalizar con eficacia, un avance que se ve reforzado al incrementar la variedad del conjunto de datos de entrenamiento.

El desafío de la falta de coherencia en rostros y estilos

Aunque en ocasiones los resultados rozan la perfección, en otras apenas logran reflejar fielmente la esencia del sujeto original.

Estrategias con resultados comprobados:

Para optimizar los resultados, es aconsejable prolongar el entrenamiento aumentando el número de pasos de 600 a 900, asegurándose siempre de incluir la palabra de activación específica en cada instrucción (como "sks person" en lugar de solo "person") y elevando la escala de guía (CFG) a un valor de entre 8 y 10 durante el proceso de generación.

Resolución del error "CUDA Out of Memory"

Esta sección está especialmente dirigida a perfiles técnicos que se han enfrentado a limitaciones de memoria VRAM en su GPU.

Soluciones rápidas:

Para optimizar el proceso, establezca el tamaño del lote en 1, active la opción de gradient checkpointing ( gradient_checkpointing flag) y utilice precisión mixta ( mixed_precision="fp16"). Si los errores persisten, reduzca la resolución de 1024 a 768 o, como último recurso, implemente el parámetro use_8bit_adam.

Problema: Los tiempos de entrenamiento resultan excesivos

Mi primera experiencia de entrenamiento en una tarjeta 3060 se prolongó durante dos horas, lo que representó un tiempo de espera excesivamente largo.

Factores clave para el éxito:

Optimice sus procesos utilizando LoRA en lugar de un ajuste fino completo para aumentar la velocidad hasta cinco veces, y prefiera resoluciones de 512px sobre las de 1024px durante las pruebas iniciales. Reducir el entrenamiento a 800 pasos resulta más que suficiente en la mayoría de los escenarios, aunque si busca la máxima eficiencia, siempre puede optar por invertir 0,80 $ por 30 minutos de potencia con una 4090 en RunPod; después de todo, el tiempo es dinero.

8. ¿Y qué ocurre con FLUX.1, el modelo más reciente?

Lanzado a mediados de 2024 por Black Forest Labs —estudio conformado por parte del equipo original de Stable Diffusion—, FLUX.1 se posiciona como una alternativa superior a SDXL en la gran mayoría de los escenarios, destacando especialmente en:

Interpretación precisa de instrucciones complejas

Optimice la generación de texto legible en sus imágenes, resolviendo las limitaciones críticas que presenta SDXL en este ámbito.

Se aprecia una mejora notable en la calidad del fotorrealismo.

Minimice la aparición de artefactos visuales y logre resultados impecables, eliminando errores anatómicos comunes como el exceso de dedos.

No obstante, el entrenamiento de modelos FLUX conlleva una mayor inversión y exige requisitos técnicos superiores, recomendándose una capacidad de VRAM mínima de 20 GB. Actualmente, plataformas como getimg.ai ofrecen este servicio por un coste aproximado de entre 10 y 12 dólares por modelo, sumándose a la reciente compatibilidad de Replicate; por el contrario, si opta por el entrenamiento local, será indispensable contar con una tarjeta RTX 4090 o recurrir al alquiler de equipos de alto rendimiento.

¿Merece la pena la inversión? Si busca resultados profesionales o requiere un nivel de calidad superior, la respuesta es afirmativa; no obstante, para proyectos personales o fases experimentales, SDXL continúa siendo una opción excepcional.

Reflexiones finales

En apenas dos años, entrenar generadores de imágenes IA personalizados ha dejado de ser un proceso exclusivo de laboratorios de investigación para transformarse en un proyecto de fin de semana, lo que evidencia la asombrosa democratización y accesibilidad que ha alcanzado esta tecnología.

Esta es la hoja de ruta que recomiendo para optimizar el proceso:

Le recomendamos comenzar con Replicate entrenando un primer modelo para validar si cumple con sus requisitos; de ser así, no necesitará nada más. Si por el contrario busca un mayor nivel de control o planea desarrollar decenas de modelos, le sugerimos explorar la ruta técnica. No pierda tiempo en análisis complejos: basta con 15 fotografías y una inversión de 3 dólares para empezar hoy mismo.

En un entorno donde la tecnología evoluciona constantemente y FLUX.1 ya supera a SDXL, es inevitable que surjan modelos aún más avanzados en el corto plazo; por ello, en lugar de esperar la llegada del sistema «perfecto», le recomendamos comenzar hoy mismo aprovechando todo el potencial de las herramientas disponibles actualmente.

Le deseamos mucho éxito y le recordamos que, al igual que me sucedió a mí, es natural que su primer modelo no sea perfecto; no se preocupe, ya que la verdadera maestría se adquiere fundamentalmente a través de la práctica y la experimentación constante.

Descubra las 11 mejores alternativas a Ideogram en 2026 a través de esta guía detallada, donde analizamos las herramientas de generación de imágenes por IA más punteras, sus estructuras de precios y la versatilidad de sus estilos artísticos para potenciar sus proyectos creativos.

Descubra las 11 mejores alternativas a Ideogram en 2026 a través de esta guía detallada, donde analizamos las herramientas de generación de imágenes por IA más punteras, sus estructuras de precios y la versatilidad de sus estilos artísticos para potenciar sus proyectos creativos.

Descubra nuestra comparativa exhaustiva de 2026 sobre Ideogram y Midjourney, analizando a fondo el potencial de estos generadores de imágenes IA y sus diversas estrategias de precios. Evaluamos cómo estas herramientas de diseño gráfico lideran la creación de contenido visual y el arte generado por IA, ofreciendo soluciones de diseño inteligente que abarcan desde la conversión de texto a imagen hasta la tipografía avanzada para optimizar sus proyectos profesionales.