Как обучить ИИ-генератор изображений: полное руководство 2026 года

Последнее обновление: 2026-01-22 18:08:26

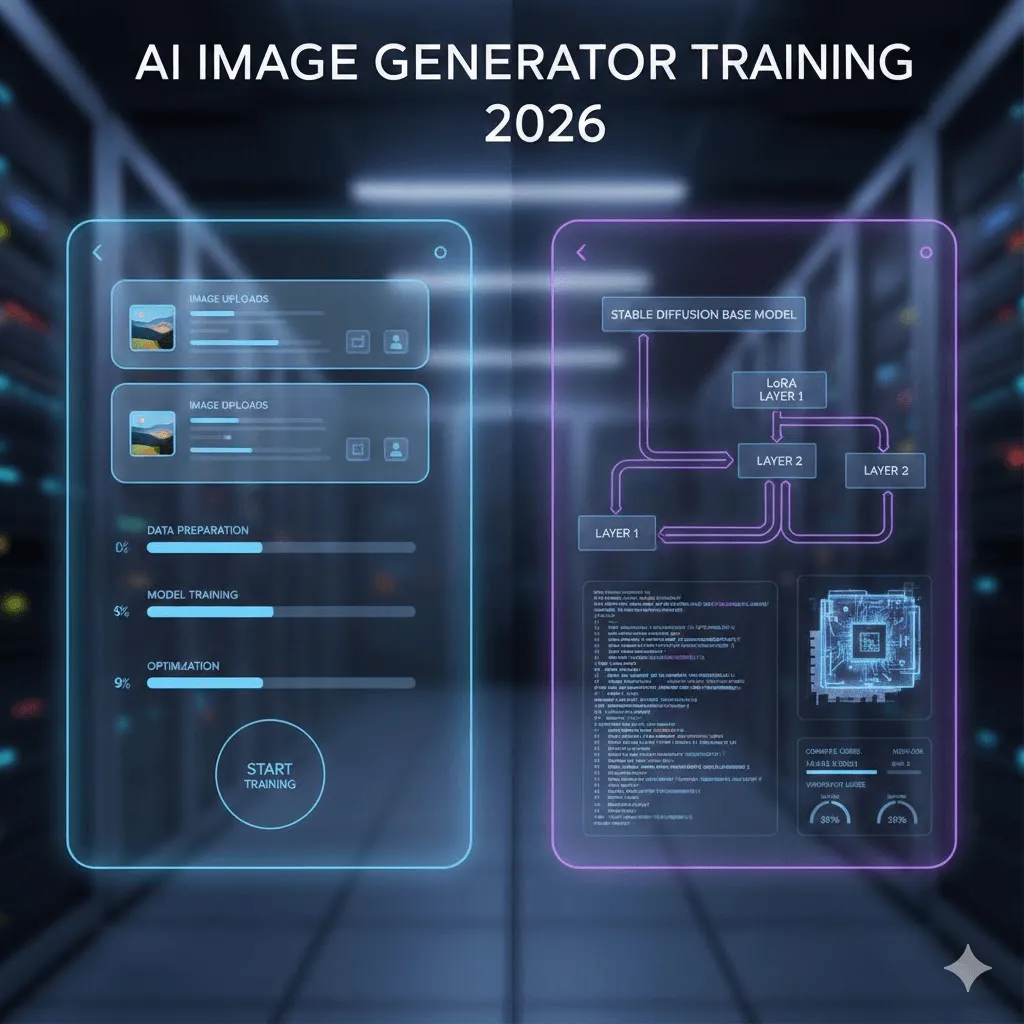

К 2026 году обучение нейросетей для генерации изображений перестало быть уделом узких специалистов: процессы, ранее требовавшие глубоких знаний машинного обучения и дорогостоящего оборудования, теперь занимают менее часа, а при выборе правильного алгоритма — не более 20 минут.

Важно понимать, что подходы к обучению ИИ существенно различаются: если одни методы привлекают скоростью и доступностью при ограниченных возможностях, то другие обеспечивают полный контроль, сопряженный с техническими сложностями. В данном руководстве мы подробно разберем оба пути, опираясь на актуальную практику и проверенные решения, а не на маркетинговые обещания или устаревшие инструкции.

В данном руководстве рассматриваются два подхода: no-code решения, позволяющие обучить модель всего за 20 минут и примерно 3 доллара, а также профессиональный путь для тех, кто хочет освоить DreamBooth, LoRA и кастомные скрипты. Я честно поделюсь личным опытом, разобрав эффективные методики и типичные сложности, с которыми вы можете столкнуться в процессе настройки.

Быстрая навигация

Если вы хотите быстро обучить модель на собственных фотографиях и сразу приступить к генерации изображений, переходите к разделу 3, где представлено подробное руководство по работе с Replicate.

Разработчикам, стремящимся к полному контролю над процессом, рекомендуем сразу перейти к разделу 4, посвященному техническим аспектам обучения.

Если вы не уверены, какой из подходов к обучению подходит именно вам, рекомендуем ознакомиться с подробностями в данном разделе.

1. Что в действительности представляет собой процесс обучения ИИ?

Для начала стоит прояснить важный момент и устранить существующую путаницу: когда говорят об «обучении ИИ-генератора изображений», речь почти никогда не идет о создании модели с нуля, так как подобный процесс потребовал бы наличия собственного дата-центра и колоссальных вложений, исчисляемых сотнями тысяч долларов.

На практике процесс представляет собой тонкую настройку уже существующей модели: Stable Diffusion уже обладает базовыми навыками изображения людей, предметов и стилей, а ваша задача — обучить её специфике конкретного образа или продукта, используя всего 10–50 примеров.

Возможности обучения: практические примеры и кейсы

Люди и персонажи: Обучение модели всего на 18 фотографиях позволяет генерировать любые персонализированные образы — от серфинга и деловых встреч до превращения в героя мультфильма. Благодаря детальному освоению черт лица система безошибочно воспроизводит нужный облик при использовании специального триггерного слова («ohw person»).

Товары: Данная технология получила широкое распространение в сфере электронной коммерции: обучив модель всего на 20 снимках продукта с разных ракурсов, вы сможете создавать неограниченное количество профессиональных рекламных материалов в любых декорациях, что обходится существенно дешевле организации традиционных фотосессий.

Художественные стили: примечательно, что загрузки всего 30 примеров ваших иллюстраций достаточно для того, чтобы модель научилась адаптировать этот стиль к любым новым сюжетам; многие студии уже успешно используют данный подход для масштабирования своего визуального бренда.

Подробный сравнительный обзор Ideogram и Midjourney в 2026 году: глубокий анализ возможностей ИИ-генераторов изображений и актуальных стратегий ценообразования.

2. Два подхода к обучению: выберите оптимальное решение под ваши задачи

Будем честны: для большинства пользователей оптимальным выбором станут no-code платформы. Несмотря на стремление разработчиков настраивать всё вручную, такой подход целесообразен лишь при необходимости в специфических параметрах обучения или глубоком изучении архитектуры; в остальных же случаях инструменты без программирования обеспечивают 90% желаемого результата при минимальных затратах времени и сил.

Подробный сравнительный обзор Ideogram и Midjourney в 2026 году: глубокий анализ возможностей ИИ-генераторов изображений и актуальных стратегий ценообразования.

Критерий сравнения | No-code платформы | Технический подход |

Время до получения результата | от 15 до 30 минут | 3–8 часов (настройка и обучение) |

Начальные вложения | 2–10 $ за одну модель | Бесплатно (локальная GPU) или 0,5–5 $ в облаке |

Требования к навыкам | Не требуются: достаточно просто загрузить фотографии | Знание Python, командной строки и архитектуры GPU |

Потенциал качества | Стабильно высокий уровень (готовность на 90%) | Возможность добиться идеала за счет тонкой ручной настройки |

Когда стоит выбрать | Если результат нужен быстро и требуется обучить 1–5 моделей | Для массового обучения (более 50 моделей), при необходимости полного контроля или изучении основ ML |

3. Кратчайший путь: обучение моделей на no-code платформах

На основе сравнительного анализа пяти различных платформ мы отобрали наиболее эффективные решения, доказавшие свою работоспособность на практике.

Replicate: оптимальная точка входа и мой проверенный выбор

Стоимость одной сессии обучения составляет около 2,50 $, а генерация каждого готового изображения обойдется примерно в 0,03 $.

Процесс обучения занимает от 18 до 25 минут

Выбор в пользу Replicate продиктован оптимальным соотношением цены и качества в сочетании с лаконичным интерфейсом без лишних сложностей. Весь процесс — от загрузки изображений до завершения обучения — реализован максимально просто и дополнен на редкость доступной и понятной документацией.

Пошаговое руководство: реальный процесс обучения без маркетинговых прикрас

Подготовка исходных изображений:

Опыт обучения модели на 18 собственных снимках показал, что разнообразие выборки гораздо важнее её объёма: если первая попытка с 30 однотипными портретами привела к простому заучиванию конкретных поз, то вторая итерация всего с 18 кадрами в разных ракурсах, при различном освещении и в полный рост обеспечила значительно более качественный результат.

Минимально допустимое разрешение составляет 512×512 пикселей, однако использование формата 1024×1024 позволяет добиться более точных результатов обучения. Крайне важно выбирать четкие снимки без размытия и избегать агрессивных фильтров или бьюти-приложений, так как для создания качественной модели ИИ необходимы ваши подлинные черты, а не их искусственно сглаженные версии.

Подробный сравнительный обзор Ideogram и Midjourney в 2026 году: глубокий анализ возможностей ИИ-генераторов изображений и актуальных стратегий ценообразования.

Процесс загрузки данных:

Перейдите на сайт replicate.com и зарегистрируйтесь, указав платежную информацию для активации аккаунта (в том числе на бесплатном тарифе), после чего откройте раздел обучения. Вы можете загружать изображения по отдельности, однако для работы с выборками более чем из 10 снимков рекомендуется использовать ZIP-архив, что существенно ускорит процесс подготовки данных.

Триггерное слово (критически важный аспект):

Для эффективного обучения модели выберите редкий уникальный идентификатор, например «ohw person» (на основе ваших инициалов); при этом важно избегать простых слов вроде «john» или «photo», которые уже знакомы нейросети. Благодаря функции автоматической генерации описаний с использованием выбранных триггеров, платформа возьмет на себя разметку данных, избавив вас от необходимости подписывать каждое изображение вручную.

Параметры обучения

Для достижения оптимального результата рекомендуется придерживаться стандартных настроек: например, установленные в Replicate по умолчанию ~800 шагов обучения подходят для большинства сценариев. Несмотря на то, что эти параметры можно корректировать вручную, начинать лучше с базовых конфигураций. Если же вы столкнетесь с эффектом переобучения (overfitting), при котором нейросеть слишком буквально копирует исходные снимки, в следующий раз попробуйте уменьшить количество шагов до 500–600.

В ожидании результата: особенности процесса обучения

Обучение на базе 18 изображений занимает примерно 22 минуты, по окончании которых вам придет уведомление на электронную почту. Учитывайте, что индикатор прогресса зачастую бывает излишне оптимистичен: если система сообщает об оставшихся 5 минутах, в реальности процесс может занять вдвое больше времени.

Подробный сравнительный обзор Ideogram и Midjourney в 2026 году: глубокий анализ возможностей ИИ-генераторов изображений и актуальных стратегий ценообразования.

Тестирование и проверка результатов обучения:

Теперь начинается самый увлекательный этап — тестирование готовой модели. Начните с простых запросов, используя ваше уникальное триггерное слово (например, «фотография улыбающегося ohw человека»), а затем переходите к более смелым экспериментам: создайте образ супергероя или сгенерируйте профессиональный портрет в строгом деловом стиле.

Профессиональный совет: использование негативных промптов позволяет существенно повысить качество генерации и избежать появления таких дефектов, как лишние пальцы или визуальные искажения. Добавление в соответствующее поле параметров «blurry, low quality, deformed, distorted» гарантирует более чистый и профессиональный результат за счет эффективного отсеивания низкокачественных элементов.

Другие платформы, заслуживающие внимания

Проведенные тесты показали, что данные инструменты наиболее эффективны при работе с узкоспециализированными сценариями использования:

getimg.ai: Несмотря на более высокую стоимость ($8–10 за модель), платформа предлагает интуитивно понятный интерфейс и поддержку обучения FLUX.1, что гарантирует превосходное качество проработки сложных сцен и делает её идеальным выбором для профессиональной работы.

Leonardo.Ai: ориентирована на разработчиков игр и концепт-художников, предоставляя бесплатный тарифный план для ознакомления с возможностями сервиса. Несмотря на более насыщенный интерфейс по сравнению с Replicate, платформа обеспечивает неизменно высокое качество обучения моделей.

ImagineArt: платформа обеспечивает высокую скорость обучения (менее 15 минут) и поддерживает интегрированную генерацию видео, позволяя анимировать созданных персонажей; это многообещающее решение, которое заслуживает внимания даже при необходимости дополнительного тестирования.

4. Технический подход: Обучение моделей на базе Stable Diffusion

Выбор более глубокого и технически сложного подхода к обучению моделей заслуживает уважения, поэтому мы подготовили для вас исчерпывающий материал. В этом руководстве собраны ключевые рекомендации, которые помогут избежать изнурительной отладки CUDA и других технических трудностей, сэкономив вам десятки часов работы на старте.

Зачем инвестировать в техническое обучение ИИ-моделей?

Будем откровенны: большинству пользователей это может не потребоваться, однако существует ряд веских причин для тонкой настройки собственных моделей:

При обучении десятков или сотен моделей расходы на использование no-code инструментов неизбежно растут и со временем становятся весьма существенными.

Для качественного обучения моделей необходим доступ к специфическим параметрам настройки, которые зачастую скрыты от пользователей стандартных платформ.

Вы работаете с конфиденциальными данными, обработка которых должна происходить строго внутри вашей собственной инфраструктуры.

Стремление детально разобраться в принципах работы данных технологий — это вполне обоснованное и логичное желание.

Три ключевых метода обучения

DreamBooth: разработанная Google технология обучения моделей новым «концептам» на основе 5–20 изображений и уникального токена-идентификатора, идеально подходящая для детального воспроизведения лиц и конкретных объектов. Несмотря на то, что в оригинальном исследовании эффективность метода демонстрировалась всего на 3–5 снимках, практика показывает, что для достижения наиболее стабильных и качественных результатов оптимально использовать от 15 до 20 исходных изображений.

LoRA (Low Rank Adaptation): эта революционная технология полностью меняет подход к работе, позволяя создавать компактные «адаптеры» весом всего 3–50 МБ вместо модификации громоздких исходных файлов объемом 5–7 ГБ. Благодаря LoRA процесс обучения ускоряется в 3–5 раз и становится доступным на стандартных игровых видеокартах, обеспечивая при этом качество, практически идентичное результатам полной тонкой настройки.

Данный метод является оптимальным решением для 95% опытных пользователей, так как комбинация DreamBooth и LoRA обеспечивает идеальный баланс между эффективностью обучения и качеством результата.

Полная тонкая настройка модели: Этот метод предполагает переобучение всей нейросети и требует значительных аппаратных ресурсов (от 24 ГБ видеопамяти), однако для большинства задач технология LoRA позволяет достичь сопоставимых результатов при использовании лишь малой части мощностей. Практический опыт показывает, что даже многочасовое обучение на высокопроизводительных GPU уровня A100 редко дает заметное преимущество в качестве, что делает LoRA наиболее эффективным и рациональным выбором.

Что вам действительно потребуется для начала работы

Аппаратное обеспечение: реальные системные требования

Минимальным системным требованием является видеокарта NVIDIA с объемом памяти 12 ГБ. И хотя модель RTX 3060 позволяет обучить LoRA за 45 минут, для максимально эффективной локальной работы оптимальным выбором станут карты уровня RTX 4070 или 3080 с 16 ГБ памяти, обеспечивающие наилучшее сочетание скорости и производительности.

При отсутствии собственного графического процессора вы можете воспользоваться облачными платформами RunPod или vast.ai, где стоимость одной сессии обучения варьируется от $0,50 до $2. Альтернативный вариант — подписка Google Colab Pro за $10 в месяц, обеспечивающая безлимитный доступ, хотя в периоды пиковой нагрузки может потребоваться ожидание в очереди.

Программное обеспечение:

Python 3.10+ (в версии 3.11 возможны проблемы с совместимостью)

Библиотека PyTorch с поддержкой технологии CUDA

Библиотека diffusers от Hugging Face

Использование библиотек accelerate, transformers и peft для реализации обучения по методу LoRA.

Практический процесс обучения: методы DreamBooth и LoRA

Мы не будем детально останавливаться на базовой настройке среды Python и использовании команды pip, так как эти этапы наверняка знакомы подготовленному читателю; вместо этого сосредоточимся на действительно ключевых аспектах процесса.

Установка одной командой — проверенное решение, которое действительно работает:

pip install diffusers[torch] transformers accelerate peft bitsandbytes

Скрипт обучения:

Чтобы не перегружать руководство избыточными блоками кода, мы сразу перейдем к сути: наиболее эффективным инструментом является официальный скрипт обучения из репозитория diffusers от Hugging Face. Это стабильное и регулярно обновляемое решение, ключевые параметры которого приведены ниже:

Скорость обучения: оптимальным значением является 1e-4. В отличие от 1e-5, замедляющего процесс, или 5e-4, ведущего к дестабилизации модели, именно этот показатель обеспечивает идеальный баланс и гарантирует качественный результат обучения.

Количество шагов обучения: для большинства задач оптимальным считается диапазон от 800 до 1000 шагов, так как меньшее значение не обеспечит нужной глубины проработки, а превышение этого порога чревато риском переобучения модели.

Размер пакета (Batch size): рекомендуется использовать значение 1 или 2, так как при обучении LoRA ресурсы видеопамяти большинства графических процессоров не позволяют устанавливать более высокие параметры.

Ранг LoRA: рекомендуется использовать значения 16 или 32. Учтите, что более высокий ранг расширяет возможности модели, но замедляет процесс обучения: если для генерации лиц достаточно показателя 16, то для проработки сложных художественных стилей лучше выбрать 32.

Подробный сравнительный обзор Ideogram и Midjourney в 2026 году: глубокий анализ возможностей ИИ-генераторов изображений и актуальных стратегий ценообразования.

Пример фактически использованной команды:

accelerate launch train_dreambooth_lora_sdxl.py \

название_или_путь_предобученной_модели="stabilityai/stable diffusion xl base 1.0" \

instance_data_dir="./my_training_images" \

instance_prompt="фотография человека sks" \

resolution=1024 \

train_batch_size=1 \

learning_rate=1e 4 \

max_train_steps=800 \

использование LoRA \

lora_r=16 \

директория_вывода="./output_lora"

На видеокарте RTX 3060 обучение заняло 38 минут; при использовании RTX 4090 это время сократится до 15 минут, в то время как на бесплатном ускорителе T4 в Google Colab процесс может потребовать более полутора часов.

5. Подготовка датасета: критический этап, определяющий успех всей модели

Мы выделили этот раздел особо, так как именно качеству подготовки данных, зачастую игнорируемому в других руководствах, отводится решающая роль: успех обучения на 80% зависит от используемого датасета и лишь на 20% — от конфигурации технических параметров.

Практические правила, выведенные опытным путем

Оптимальный объем выборки — от 15 до 25 изображений. Хотя часто встречаются рекомендации использовать всего 5–10 кадров, этого набора достаточно лишь для простейших объектов; при этом расширение датасета до 40 снимков и более не дает качественного преимущества, а лишь увеличивает время обучения.

Правильный выбор разрешения: Для корректной работы моделей SD 1.5 и SDXL необходимо использовать изображения размером не менее 512×512 и 1024×1024 пикселей соответственно. Вместо загрузки необработанных фотографий высокого разрешения (например, 4000×3000), которые лишь замедляют процесс, предварительно приведите их к рекомендованным параметрам для обеспечения максимальной эффективности обучения.

Разнообразие важнее количества: этот ключевой принцип невозможно переоценить, ведь 15 разнообразных снимков с разных ракурсов и в разном контексте дадут лучший результат, чем 30 однотипных. При обучении модели на конкретном человеке обязательно комбинируйте крупные планы и фото в полный рост, используя кадры с разным освещением, мимикой и вариантами одежды.

Типичные ошибки при подготовке датасетов: разбор на основе личного опыта

Отказ от фильтров и ретуши: избегайте использования фотографий с фильтрами Instagram, бьюти-режимами или глубокой постобработкой, так как модель может усвоить наложенные визуальные искажения вместо ключевых характеристик самого объекта.

Неоднородное освещение: хотя умеренная вариативность полезна для обучения, резкий контраст между кадрами при ярком дневном свете и в приглушенном клубном интерьере может помешать модели корректно интерпретировать данные.

Несколько человек в кадре: При создании модели на основе вашей внешности обязательно обрезайте фотографии, удаляя посторонних лиц, чтобы избежать смешения черт. В моей практике был случай, когда нейросеть начала воспроизводить чужую прическу лишь потому, что этот человек присутствовал всего на трех снимках из обучающей выборки.

Водяные знаки и текст: во избежание их копирования моделью обязательно удалите или обрежьте данные элементы на исходных изображениях.

Подробный сравнительный обзор Ideogram и Midjourney в 2026 году: глубокий анализ возможностей ИИ-генераторов изображений и актуальных стратегий ценообразования.

6. Подробный расчет реальных затрат

Рассмотрим финансовую составляющую: ниже представлен детальный отчет о фактических расходах на комплексное тестирование данных решений.

Подробный сравнительный обзор Ideogram и Midjourney в 2026 году: глубокий анализ возможностей ИИ-генераторов изображений и актуальных стратегий ценообразования.

Платформа | Обучение | За одно изображение | Вердикт |

Replicate | $2.47 | $0.028 | Оптимальное соотношение цены и качества |

getimg.ai | $8.00 | $0.05~0.08 | Оправданный выбор для работы с моделями FLUX |

Leonardo.Ai | Бесплатно — $10 | Варьируется | Подходит для первичного ознакомления и тестов |

Google Colab Pro | $10/мес (безлимит) | $0 | Эффективно при создании 10 и более моделей |

RunPod (RTX 3090) | ~$0.80 | $0 (собственный хостинг) | Идеальный баланс характеристик для разработчиков |

Локальная GPU | ~$0.15 (затраты на электричество) | $0 | Лучшее решение при наличии собственного оборудования. |

7. Решение проблем: типичные сложности и способы их устранения

Ниже представлен разбор реальных сложностей и проверенные способы их решения, которые помогут вам избежать типичных ошибок и значительно упростить процесс обучения моделей.

Проблема переобучения: когда модель лишь копирует исходные фотографии

Данное явление называется переобучением: в этом случае при генерации по запросу «sks person at the beach» модель фактически воспроизводит исходный тренировочный снимок, просто перенося объект в локацию пляжа.

Что показало свою эффективность:

Сокращение количества шагов обучения с 1000 до 600 обеспечило мгновенный прирост качества: модель перестала просто заучивать данные, начав эффективно их обобщать, а повышение вариативности обучающей выборки позволило добиться еще более впечатляющих результатов.

Проблема: Нестабильность лиц и стилей

Результаты обучения могут быть неоднородными: от безупречного исполнения до лишь отдаленного сходства с исходным объектом.

Что показало свою эффективность:

Для достижения наилучших результатов рекомендуется увеличить длительность обучения, например с 600 до 900 шагов, при этом крайне важно всегда указывать в промпте уникальное триггерное слово (используя «sks person» вместо обычного «person») и устанавливать параметр Guidance Scale (CFG) в диапазоне 8–10 в процессе генерации.

Проблема: ошибка нехватки видеопамяти «CUDA Out of Memory»

Данный раздел предназначен для технических специалистов, столкнувшихся с проблемой нехватки видеопамяти (VRAM) на своем графическом процессоре.

Способы оперативного исправления:

Для оптимизации ресурсов установите размер пакета (batch size) на 1, активируйте параметр gradient_checkpointing и используйте смешанную точность ( mixed_precision="fp16"). В случае возникновения ошибок рекомендуется снизить разрешение с 1024 до 768 либо в качестве крайней меры задействовать use_8bit_adam.

Проблема: Избыточная длительность процесса обучения

Мой первый опыт обучения на видеокарте RTX 3060 занял целых два часа, что оказалось неоправданно долго для эффективного рабочего процесса.

Что помогло добиться результата:

Для пятикратного ускорения процесса используйте технологию LoRA вместо полной тонкой настройки модели, ограничившись на этапе тестирования разрешением 512px и 800 шагами обучения. Если же вы стремитесь к максимальной эффективности, аренда RTX 4090 на RunPod обойдется всего в $0.80 за полчаса, позволяя существенно сэкономить ваше время.

8. FLUX.1: обзор и перспективы модели нового поколения

Представленная в середине 2024 года командой Black Forest Labs, объединившей ключевых разработчиков оригинальной Stable Diffusion, модель FLUX.1 во многих аспектах превосходит SDXL, демонстрируя исключительную эффективность в таких задачах, как:

Точное исполнение сложных и детализированных текстовых запросов

Создание качественного и разборчивого текста на изображениях, что является одной из наиболее сложных задач для стандартной модели SDXL.

Качество фотореализма стало заметно выше

Минимизация визуальных артефактов и повышение анатомической точности, избавляющей от появления лишних пальцев на изображениях.

Однако стоит учитывать повышенную стоимость обучения и строгие требования к ресурсам: для работы потребуется не менее 20 ГБ видеопамяти. В то время как сервисы getimg.ai и Replicate предлагают облачное обучение моделей FLUX по цене около 10–12 долларов, для локального запуска вам понадобится видеокарта уровня RTX 4090 или аренда высокопроизводительных мощностей.

Оправдан ли такой подход? Безусловно, если ваша цель — профессиональный результат и бескомпромиссное качество, в то время как для личных проектов и экспериментов возможностей SDXL по-прежнему вполне достаточно.

Заключение

Всего за два года обучение пользовательских ИИ-генераторов совершило колоссальный путь: то, что раньше было прерогативой исследовательских лабораторий, сегодня превратилось в доступный проект на выходные, став по-настоящему открытой технологией для каждого.

Рекомендуемый алгоритм действий для достижения наилучших результатов:

Начните работу с платформой Replicate: обучите свою первую модель и оцените полученный результат. Если он полностью отвечает вашим задачам, то цель достигнута. В случае же, если вам необходим расширенный контроль или масштабирование до десятков моделей, стоит переходить к изучению более сложных технических подходов. Главное — не усложнять процесс на старте: для запуска обучения вам потребуется всего 15 фотографий и около 3 долларов.

Технологии непрерывно развиваются: сегодня FLUX.1 демонстрирует лучшие результаты, чем SDXL, а всего через полгода появится еще более совершенное решение. Не стоит ждать «идеальной» модели — начните работу с актуальными инструментами уже сейчас, чтобы оставаться на острие прогресса.

Желаем вам успехов и помните: первая модель вряд ли сразу станет безупречной, но это совершенно нормально, ведь истинное мастерство в работе с ИИ приходит только с практическим опытом.

Представляем обзор 11 лучших альтернатив Ideogram в 2026 году: подробный анализ возможностей ИИ-генераторов изображений, ценовой политики и доступных художественных стилей.

Представляем обзор 11 лучших альтернатив Ideogram в 2026 году: подробный анализ возможностей ИИ-генераторов изображений, ценовой политики и доступных художественных стилей.

Подробный сравнительный обзор Ideogram и Midjourney в 2026 году: глубокий анализ возможностей ИИ-генераторов изображений и актуальных стратегий ценообразования.