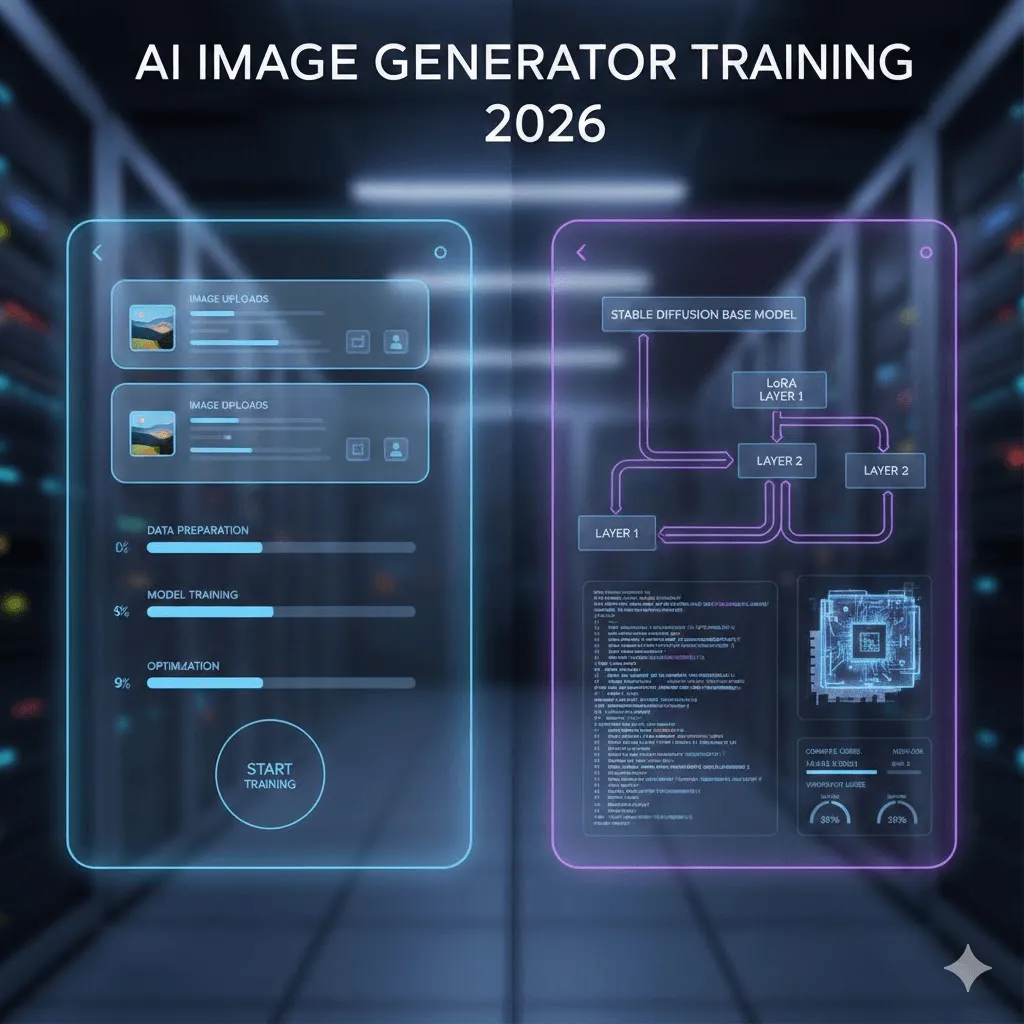

Comment entraîner un générateur d’images par IA : le guide complet 2026

Dernière mise à jour: 2026-01-22 18:08:26

En 2026, l'entraînement d'un générateur d'images par IA n'est plus l'apanage des experts : autrefois tributaire de connaissances pointues en machine learning, de GPU onéreux et de semaines d'expérimentation, ce processus s'accomplit désormais en moins d'une heure — et parfois même en vingt minutes seulement — pour peu que l'on choisisse la méthode adéquate.

Toutefois, les méthodes d'entraînement d'IA varient considérablement : alors que certaines privilégient la rapidité et le coût au détriment de la flexibilité, d'autres offrent un contrôle total au prix d'une complexité technique accrue. Ce guide détaille ces deux approches de manière pragmatique, en se fondant sur les standards technologiques actuels plutôt que sur des promesses marketing ou des tutoriels obsolètes.

Ce guide détaille deux approches distinctes : une méthode sans code permettant d'entraîner un modèle en seulement 20 minutes pour environ 3 $, ainsi qu'un parcours technique approfondi dédié à DreamBooth, LoRA et aux scripts personnalisés. En m'appuyant sur mon propre retour d'expérience, je partage en toute transparence les solutions efficaces et les pièges récurrents pour vous aider à franchir sereinement les étapes où j'ai moi-même rencontré des difficultés.

Accès rapide

Accédez directement à la section 3 (tutoriel Replicate) si vous souhaitez entraîner un modèle à votre image afin de générer vos propres photos par IA.

Pour les développeurs en quête d'un contrôle total sur leurs modèles, rendez-vous directement à la section 4 consacrée à l'entraînement technique.

Vous hésitez sur la stratégie à adopter ? Poursuivez votre lecture pour découvrir la méthode d'entraînement la mieux adaptée à votre projet.

1. En quoi consiste réellement l'entraînement d'une IA ?

Levons d’abord une ambiguïté fréquente : lorsqu’il est question d’entraîner un générateur d’images par IA, il s’agit rarement de concevoir un modèle de toutes pièces, une entreprise qui exigerait des infrastructures colossales et des investissements s'élevant à plusieurs centaines de milliers de dollars.

Le principe repose sur l'ajustement de modèle (fine-tuning) : alors que Stable Diffusion maîtrise déjà la représentation de sujets variés, vous allez lui apprendre à reconnaître votre propre personne, produit ou style spécifique grâce à une simple sélection de 10 à 50 images de référence.

Possibilités d'entraînement et cas d'usage concrets

Personnes et personnages : Grâce à un entraînement réalisé à partir de seulement 18 photos personnelles, le modèle a parfaitement assimilé mes traits physiques, me permettant ainsi de générer des images de moi-même dans n'importe quelle situation. Qu'il s'agisse de me représenter en train de surfer, en costume professionnel ou même en personnage de dessin animé, il me suffit désormais d'utiliser le mot-clé d'activation (« ohw person ») pour obtenir un résultat sur mesure.

Produits : Particulièrement plébiscitée par les marques d'e-commerce, cette technologie permet de générer une infinité de visuels marketing dans des décors variés à partir de seulement vingt clichés de votre produit sous différents angles, offrant ainsi une alternative nettement plus économique aux séances photo traditionnelles.

Styles artistiques : cette approche est particulièrement prometteuse. En lui soumettant une trentaine d'exemples de vos propres illustrations, l'IA parvient à en reproduire fidèlement l'esthétique sur de nouveaux sujets, une méthode déjà adoptée par de nombreux studios pour automatiser l'application de leur identité visuelle.

Découvrez notre analyse comparative approfondie 2026 entre Ideogram et Midjourney, une étude complète des performances de ces générateurs d'images par IA et de leurs structures tarifaires respectives.

2. Deux approches : choisissez la méthode adaptée à votre profil

Soyons réalistes : pour la majorité des utilisateurs, privilégier d'emblée les plateformes "no-code" constitue la stratégie la plus judicieuse. Si l'envie de tout concevoir soi-même est tentante, le sans-code permet d'obtenir 90 % des résultats avec seulement 10 % de l'effort investi, à moins de nécessiter des paramètres d'entraînement ultra-spécifiques ou de vouloir maîtriser chaque rouage technique de l'IA.

Découvrez notre analyse comparative approfondie 2026 entre Ideogram et Midjourney, une étude complète des performances de ces générateurs d'images par IA et de leurs structures tarifaires respectives.

Critères de comparaison | Plateformes No-Code | Approche Technique |

Délai de mise en œuvre | 15 à 30 minutes | 3 à 8 heures (installation et entraînement) |

Investissement initial | 2 à 10 $ par modèle | Gratuit (GPU local) ou 0,50 à 5 $ (Cloud) |

Compétences requises | Aucune : un simple import de photos suffit | Python, ligne de commande et notions de GPU |

Niveau de qualité | Excellente (proche de 90 % du potentiel) | Potentiellement supérieur via l'optimisation |

Cas d'usage idéal | Besoin immédiat pour l'entraînement de 1 à 5 modèles | Production intensive (50+ modèles), contrôle total ou apprentissage du Machine Learning. |

3. La voie rapide : l'entraînement simplifié grâce aux plateformes no-code

Après avoir mis à l'épreuve cinq plateformes différentes, voici les solutions qui se sont révélées les plus efficaces.

Replicate : le point de départ idéal et ma solution de prédilection

Prévoyez un investissement d'environ 2,50 $ par session d'entraînement, pour un coût de revient s'élevant à peine à 0,03 $ par image générée.

Prévoyez environ 18 à 25 minutes pour finaliser l'entraînement de votre modèle.

Pourquoi privilégier Replicate ? Cette solution offre un rapport qualité-prix optimal via une interface épurée où l'entraînement s'effectue simplement dès l'importation de vos images, tout en bénéficiant d'une documentation d'une clarté exemplaire, un atout rare dans ce domaine.

Guide pas à pas : la réalité du processus, loin des discours marketing

Optimisation et préparation de votre jeu de données d'images :

S’appuyant sur l’utilisation de 18 photos personnelles, cette expérience démontre que la diversité des images prime largement sur leur quantité. En effet, là où une première tentative avec 30 portraits similaires avait limité le modèle à une simple mémorisation de poses identiques, un second essai regroupant 18 clichés aux angles, éclairages et cadrages variés — incluant des plans en pied — a permis d’obtenir des résultats bien plus performants.

Pour un rendu optimal, privilégiez une résolution de 1024x1024 pixels, bien que le format minimal accepté soit de 512x512. Veillez à utiliser des images d'une netteté parfaite et dépourvues de filtres ou de retouches lissantes, car l'IA doit pouvoir identifier précisément vos traits naturels pour les reproduire fidèlement, sans altération artificielle.

Découvrez notre analyse comparative approfondie 2026 entre Ideogram et Midjourney, une étude complète des performances de ces générateurs d'images par IA et de leurs structures tarifaires respectives.

Le processus de mise en ligne :

Rendez-vous sur replicate.com pour créer votre compte, en veillant à renseigner vos coordonnées de paiement nécessaires à l'activation, puis accédez à la section dédiée à l'entraînement. Pour importer vos visuels, vous avez le choix entre un téléchargement individuel ou l'utilisation d'une archive ZIP, cette dernière solution étant recommandée pour optimiser le processus au-delà de dix images.

Le mot-clé déclencheur (un paramètre essentiel) :

Il est essentiel de choisir un identifiant unique et peu commun, tel que « ohw person » ou « zxc person », afin d'éviter toute confusion avec des termes déjà intégrés au modèle comme « john » ou « photo ». En s'appuyant sur ces mots-clés spécifiques, la plateforme génère automatiquement les légendes de vos images, vous épargnant ainsi l'étape fastidieuse de l'étiquetage manuel.

Paramètres d’entraînement :

Pour garantir des résultats optimaux, nous recommandons de conserver les paramètres par défaut proposés par Replicate, soit environ 800 étapes d'entraînement, une configuration qui s'avère efficace dans la plupart des scénarios. Bien que vous puissiez personnaliser ce réglage, privilégiez d'abord les valeurs standards ; si vous observez un phénomène de surapprentissage — où l'IA reproduit trop littéralement vos photos sources — réduisez alors le nombre d'étapes entre 500 et 600 lors de votre prochaine tentative.

La phase d’attente :

L'entraînement de mes 18 images a duré 22 minutes, au terme desquelles une notification de confirmation vous sera envoyée par e-mail. Notez toutefois que la barre de progression s'avère souvent optimiste : lorsqu'elle indique 5 minutes restantes, prévoyez en réalité une attente de 10 minutes.

Découvrez notre analyse comparative approfondie 2026 entre Ideogram et Midjourney, une étude complète des performances de ces générateurs d'images par IA et de leurs structures tarifaires respectives.

Évaluation et mise à l'épreuve de votre modèle

C'est ici que l'expérience prend tout son sens : commencez par tester des requêtes simples intégrant votre mot-déclencheur, telles que « une photo de ohw person souriant », avant de laisser libre cours à votre créativité avec des mises en scène plus élaborées, comme un portrait en super-héros ou un cliché professionnel en tenue d'affaires.

Conseil d'expert : optimisez la précision de vos rendus en intégrant des prompts négatifs tels que « flou, mauvaise qualité, déformé » ou « distordu ». Cette approche permet d'améliorer radicalement la qualité finale tout en prévenant l'apparition d'anomalies structurelles et d'artefacts indésirables, tels que les doigts surnuméraires, que le modèle a parfois tendance à générer.

D'autres plateformes incontournables à découvrir

Bien que nous ayons testé ces différentes solutions, celles-ci s'avèrent plus pertinentes pour répondre à des cas d'usage spécifiques.

getimg.ai : Bien que plus onéreuse avec un tarif de 8 à 10 $ par modèle, cette plateforme se distingue par une interface particulièrement soignée et la prise en charge de l'entraînement FLUX.1, dont la supériorité technique sur les scènes complexes en fait un investissement judicieux pour les professionnels.

Leonardo.Ai : Principalement destiné aux concepteurs de jeux et aux artistes conceptuels, Leonardo.Ai propose un forfait gratuit facilitant l'expérimentation de ses fonctionnalités. Si son interface s’avère plus dense que celle de Replicate, la plateforme n'en demeure pas moins une solution robuste offrant une excellente qualité d'entraînement.

ImagineArt : Se distinguant par un processus d'entraînement ultra-rapide de moins de 15 minutes, cet outil intègre désormais la génération vidéo afin d'animer vos personnages personnalisés ; une évolution prometteuse qui mérite d'être explorée de plus près.

4. L'approche technique : maîtriser l'entraînement avec Stable Diffusion

Vous avez choisi de relever le défi technique de l'entraînement manuel, une approche rigoureuse pour laquelle nous avons réuni ici tous les conseils essentiels qui vous éviteront de perdre un temps précieux à résoudre des erreurs de configuration CUDA.

Pourquoi privilégier l'entraînement technique ?

En toute transparence, si cette expertise n'est pas indispensable pour la majorité des utilisateurs, elle répond néanmoins à des objectifs spécifiques et stratégiques :

Lorsque vous entraînez des dizaines, voire des centaines de modèles, les frais liés aux solutions sans code peuvent rapidement devenir prohibitifs.

Accédez aux paramètres d'entraînement avancés et aux réglages précis que les plateformes standards ne vous permettent pas de configurer.

Vous travaillez avec des données propriétaires devant rester strictement confinées au sein de votre propre infrastructure.

Comprendre en profondeur les rouages de cette technologie est une ambition légitime pour en maîtriser tout le potentiel.

Les trois approches principales

DreamBooth : développée par Google, cette méthode permet d'enseigner un nouveau « concept » au modèle via un jeton d'identification unique et une série de 5 à 20 images. Particulièrement efficace pour représenter des personnes ou des objets spécifiques, elle gagne en stabilité et en précision avec un jeu de 15 à 20 clichés, surpassant ainsi les résultats obtenus avec les 3 à 5 images initialement suggérées par les chercheurs.

LoRA (Low Rank Adaptation) : véritable révolution technologique, cette méthode permet de s'affranchir de la modification de modèles massifs de 5 à 7 Go en créant un "adaptateur" léger de seulement 3 à 50 Mo. En plus d'accélérer l'entraînement de 3 à 5 fois, elle rend le processus accessible sur un simple processeur graphique standard tout en garantissant une qualité finale quasi identique à un ajustement complet.

Recommandée à 95 % des utilisateurs techniques, l’alliance de DreamBooth et LoRA constitue la solution privilégiée offrant un équilibre idéal.

Fine-tuning intégral : L'entraînement complet du modèle requiert une puissance de calcul conséquente, avec un minimum de 24 Go de VRAM. Toutefois, sauf cas d'usage très spécifique, la méthode LoRA s'avère bien plus efficiente : elle permet d'atteindre 95 % de performance avec seulement 10 % des ressources, rendant souvent superflus les cycles d'entraînement intensifs — comme des sessions de 6 heures sur A100 — qui n'apportent aucune amélioration qualitative notable.

Les prérequis essentiels pour bien démarrer

Configuration matérielle : les véritables prérequis techniques

La configuration minimale requise repose sur un GPU NVIDIA doté de 12 Go de VRAM ; toutefois, si une RTX 3060 permet de réaliser l'entraînement d'un LoRA en 45 minutes, l'usage d'une RTX 4070 ou 3080 avec 16 Go constitue le choix idéal pour optimiser la fluidité et la rapidité de vos traitements en local.

Si vous ne disposez pas d'un GPU, des solutions cloud comme RunPod ou vast.ai permettent d'effectuer vos entraînements pour un coût modique allant de 0,50 $ à 2 $ par session. Pour un usage plus intensif, l'abonnement Google Colab Pro à 10 $ par mois offre un accès illimité, bien que l'accès reste soumis à une file d'attente lors des pics de fréquentation.

Logiciels :

Python 3.10 ou supérieur (des problèmes de compatibilité ayant été constatés avec la version 3.11).

PyTorch avec prise en charge CUDA

La bibliothèque diffusers de Hugging Face

Optimisez vos flux de travail grâce à l'intégration des bibliothèques Accelerate et Transformers, complétées par PEFT pour un entraînement LoRA performant.

Le processus d’entraînement en pratique : DreamBooth et LoRA

Nous ferons l'impasse sur la configuration initiale de l'environnement Python pour nous concentrer sur les aspects véritablement essentiels, considérant que la gestion des dépendances est une compétence que vous maîtrisez déjà.

Installation : une commande unique et réellement opérationnelle pour un déploiement immédiat :

pip install diffusers[torch] transformers accelerate peft bitsandbytes

Script d'entraînement :

Pour vous épargner l'analyse de longs blocs de code, voici l'essentiel à retenir : privilégiez le script d'entraînement officiel issu du dépôt « diffusers » de Hugging Face. Cette ressource, maintenue rigoureusement pour garantir une efficacité optimale, s'articule autour des paramètres clés suivants :

Taux d'apprentissage : Optez pour la valeur idéale de 1e~4 car, tandis qu'un réglage à 1e~5 ralentit excessivement le processus, une hausse à 5e~4 risque d'instabiliser votre modèle.

Nombre d’étapes d’entraînement : Prévoyez généralement entre 800 et 1000 itérations pour garantir un apprentissage complet tout en évitant tout risque de surapprentissage.

Taille du lot : 1 ou 2. Nous recommandons de s'en tenir à ces valeurs, car les ressources de votre GPU ne permettront généralement pas d'excéder ce seuil lors d'un entraînement LoRA.

Rang LoRA : Une valeur comprise entre 16 et 32 permet d'ajuster l'équilibre entre capacité de traitement et rapidité d'exécution. Si un réglage à 16 convient parfaitement pour la reproduction de visages, l'utilisation d'un rang 32 est préconisée pour restituer toute la finesse de styles artistiques complexes.

Découvrez notre analyse comparative approfondie 2026 entre Ideogram et Midjourney, une étude complète des performances de ces générateurs d'images par IA et de leurs structures tarifaires respectives.

Exemple de la commande réellement exécutée :

accelerate launch train_dreambooth_lora_sdxl.py \

pretrained_model_name_or_path="stabilityai/stable diffusion xl base 1.0" \

instance_data_dir="./mes_images_entrainement" \

instance_prompt="une photo de la personne sks" \

résolution=1024 \

train_batch_size=1 \

taux_d_apprentissage=1e 4 \

max_train_steps=800 \

use_lora \

lora_r=16 \

répertoire_de_sortie="./output_lora"

Cette opération a nécessité 38 minutes sur une RTX 3060, contre moins de 15 minutes sur une RTX 4090 et plus de 90 minutes via l'instance T4 gratuite de Google Colab.

5. Préparation du dataset : le facteur déterminant pour la réussite de votre modèle

Souvent négligée par la plupart des guides, cette section constitue pourtant l’étape la plus cruciale de votre apprentissage, car la qualité de l’entraînement dépend à 80 % de la pertinence de votre jeu de données et seulement à 20 % de vos réglages techniques.

Les règles fondamentales issues de l'expérience terrain

Le volume idéal se situe entre 15 et 25 images. Si un échantillon plus restreint s’avère souvent insuffisant pour les sujets complexes, dépasser le seuil des 40 clichés n’apporte aucune amélioration notable et tend simplement à ralentir inutilement le processus d’entraînement.

L'importance de la résolution : un format minimal de 512×512 pour SD 1.5 et de 1024×1024 pour SDXL est indispensable pour garantir l'efficacité de l'entraînement ; veillez donc à redimensionner vos photos au préalable plutôt que d'utiliser des fichiers bruts de smartphone dont la haute définition (4000×3000) pourrait ralentir inutilement le processus.

Privilégiez la diversité à la quantité : ce principe fondamental garantit des résultats supérieurs, où 15 visuels variés surpassent largement 30 clichés similaires. Pour optimiser l'apprentissage, multipliez les angles, les éclairages et les contextes ; s'il s'agit d'un sujet humain, veillez à alterner entre gros plans et plans larges tout en variant les expressions et les styles vestimentaires.

Les erreurs classiques de préparation des données : retour d'expérience sur les pièges à éviter

L'utilisation de photos filtrées ou retouchées : Il convient de proscrire les filtres Instagram, les modes beauté et toute retouche excessive, afin d'éviter que le modèle n'assimile les caractéristiques du filtre au détriment du sujet lui-même.

Éclairage incohérent : bien qu'une certaine variété soit bénéfique, un contraste trop marqué entre des prises de vue en plein jour et des environnements sombres risque de désorienter le modèle.

Gestion des sujets multiples : Pour un entraînement personnalisé, il est crucial de recadrer vos clichés afin d'exclure toute autre personne, évitant ainsi que le modèle ne fusionne par mégarde des caractéristiques physiques ; à titre d'exemple, la présence d'un tiers sur seulement trois photos peut suffire à ce que l'IA reproduise par erreur ses attributs, tels qu'une coiffure spécifique, sur votre propre modèle.

Filigranes et textes : afin d’éviter que le modèle n’assimile ces éléments indésirables, veillez à les supprimer ou à recadrer vos images au préalable.

Découvrez notre analyse comparative approfondie 2026 entre Ideogram et Midjourney, une étude complète des performances de ces générateurs d'images par IA et de leurs structures tarifaires respectives.

6. Analyse détaillée des coûts réels

Abordons la question du budget : voici un aperçu transparent des dépenses réelles engagées lors de nos différentes phases de test.

Découvrez notre analyse comparative approfondie 2026 entre Ideogram et Midjourney, une étude complète des performances de ces générateurs d'images par IA et de leurs structures tarifaires respectives.

Service | Coût d'entraînement | Prix par image | Notre analyse |

Replicate | 2,47 $ | 0,028 $ | Le meilleur rapport qualité-prix |

getimg.ai | 8,00 $ | 0,05~0,08 $ | Un investissement justifié pour FLUX |

Leonardo.Ai | Gratuit ~ 10 $ | Variable | Idéal pour les phases de test |

Google Colab Pro | 10 $/mois illimité | 0 $ | Rentable pour la création de plus de 10 modèles |

RunPod (RTX 3090) | ~0,80 $ | 0 $ (auto-hébergé) | Le choix de prédilection des développeurs |

GPU Local | ~0,15 $ d'électricité | 0 $ | La solution optimale si vous disposez déjà du matériel requis. |

7. Guide de dépannage : anticiper et résoudre les erreurs courantes

Afin de vous épargner toute difficulté inutile, voici un tour d'horizon des obstacles techniques que j'ai rencontrés et les solutions concrètes pour y remédier efficacement.

Problématique : le risque d'un modèle se contentant de reproduire servilement vos photos d'entraînement

Ce phénomène de surapprentissage, ou overfitting, se manifeste lorsque la génération d'une image via l'invite « sks person at the beach » se contente de reproduire quasi textuellement votre cliché d'origine sur un décor de plage.

Les points forts :

En réduisant le nombre d'étapes d'entraînement de 1 000 à 600, j'ai constaté une amélioration immédiate : le modèle a cessé de mémoriser les données pour enfin privilégier la généralisation. Cette approche, combinée à une diversification accrue du jeu de données, a permis d'optimiser considérablement la qualité des résultats.

Le défi de l'incohérence des visages et des styles

Si les résultats peuvent atteindre une perfection saisissante, il arrive également qu'ils s'éloignent de manière significative du sujet d'origine.

Les points forts :

Pour optimiser vos résultats, prolongez la phase d'entraînement en passant par exemple de 600 à 900 étapes. Assurez-vous d'inclure systématiquement votre mot déclencheur spécifique dans chaque prompt, comme « sks person » plutôt que « person », et augmentez l'échelle de guidage (CFG) entre 8 et 10 lors de la phase de génération.

Problème : l'erreur « CUDA Out of Memory »

Destiné aux profils techniques, ce volet s’adresse spécifiquement à ceux dont le processeur graphique a atteint ses limites de mémoire VRAM.

Solutions et correctifs rapides :

Configurez la taille de lot (batch size) à 1 et activez le checkpointing de gradient via l'argument gradient_checkpointing. Adoptez la précision mixte ( mixed_precision="fp16") et, si les erreurs persistent, réduisez la résolution de 1024 à 768 pixels ou utilisez l'option use_8bit_adam en dernier recours.

Problématique : des délais d'entraînement excessivement longs

À mes débuts, l'entraînement d'un modèle sur une RTX 3060 durait plus de deux heures, une attente bien trop longue pour garantir un flux de travail efficace.

Les clés de la réussite :

Optimisez votre entraînement LoRA en privilégiant cette méthode cinq fois plus rapide qu'un ajustement de modèle complet, et accélérez vos phases de test en adoptant une résolution de 512 px pour seulement 800 étapes. Pour maximiser votre productivité, vous pouvez également louer la puissance d'une RTX 4090 sur RunPod pour seulement 0,80 $ la demi-heure, car le temps reste votre ressource la plus précieuse.

8. Qu’en est-il de FLUX.1, le nouveau modèle de référence ?

Lancé à la mi-2024 par Black Forest Labs — studio composé de membres de l’équipe originelle de Stable Diffusion —, le modèle FLUX.1 surpasse désormais SDXL dans la majorité des cas de figure, s’illustrant tout particulièrement dans les domaines suivants :

Respect précis des instructions les plus complexes

Générez des textes parfaitement lisibles au sein de vos visuels, palliante ainsi l'une des lacunes majeures de SDXL en la matière.

Le rendu photoréaliste a été considérablement optimisé, offrant une fidélité visuelle nettement supérieure.

Éliminez les artefacts visuels et les anomalies anatomiques, comme les doigts superflus, pour obtenir des rendus d'une précision irréprochable.

Ce processus s'avère toutefois plus onéreux et exigeant en ressources techniques, avec un minimum de 20 Go de VRAM recommandés. Tandis que des services comme getimg.ai et Replicate permettent désormais l'entraînement FLUX — comptez environ 10 à 12 $ par modèle sur getimg.ai —, une installation locale nécessitera une carte graphique RTX 4090 ou la location d'une infrastructure cloud robuste.

L'investissement en vaut-il la peine ? Absolument, dès lors que vos impératifs professionnels exigent une qualité d'image supérieure ; pour des projets personnels ou des phases de test, SDXL demeure toutefois une solution d'excellence.

Conclusion

En à peine deux ans, l'entraînement de générateurs d'images IA personnalisés s'est radicalement démocratisé, évoluant de l'exclusivité des laboratoires de recherche vers de simples projets personnels grâce à une accessibilité désormais exceptionnelle.

Voici la méthodologie que je préconise pour optimiser vos résultats :

Débutez votre apprentissage sur Replicate en entraînant un premier modèle afin d'en évaluer les résultats : s'ils s'avèrent concluants, votre projet est terminé. Pour un contrôle accru ou une production à grande échelle, explorez alors les approches plus techniques, tout en gardant à l'esprit qu'il suffit de 15 photos et de 3 $ pour lancer votre premier essai sans attendre.

L'évolution technologique est constante : bien que FLUX.1 surpasse actuellement SDXL, de nouveaux modèles plus performants verront le jour d'ici quelques mois. Ne différez pas vos projets en attendant le modèle idéal et commencez dès maintenant à exploiter tout le potentiel des outils à votre disposition.

Bonne chance dans vos projets. Gardez à l’esprit que votre premier modèle ne sera sans doute pas parfait — le mien ne l'était pas non plus — car c’est avant tout par l’expérimentation que vous perfectionnerez votre savoir-faire.

Explorez les 11 meilleures alternatives à Ideogram en 2026 pour la génération d'images par IA, une étude comparative des tarifs et des styles artistiques de pointe.

Explorez les 11 meilleures alternatives à Ideogram en 2026 pour la génération d'images par IA, une étude comparative des tarifs et des styles artistiques de pointe.

Découvrez notre analyse comparative approfondie 2026 entre Ideogram et Midjourney, une étude complète des performances de ces générateurs d'images par IA et de leurs structures tarifaires respectives.