2026 年 AI 繪圖模型訓練指南:打造專屬生成工具的全方位教學

最後更新: 2026-01-22 18:08:26

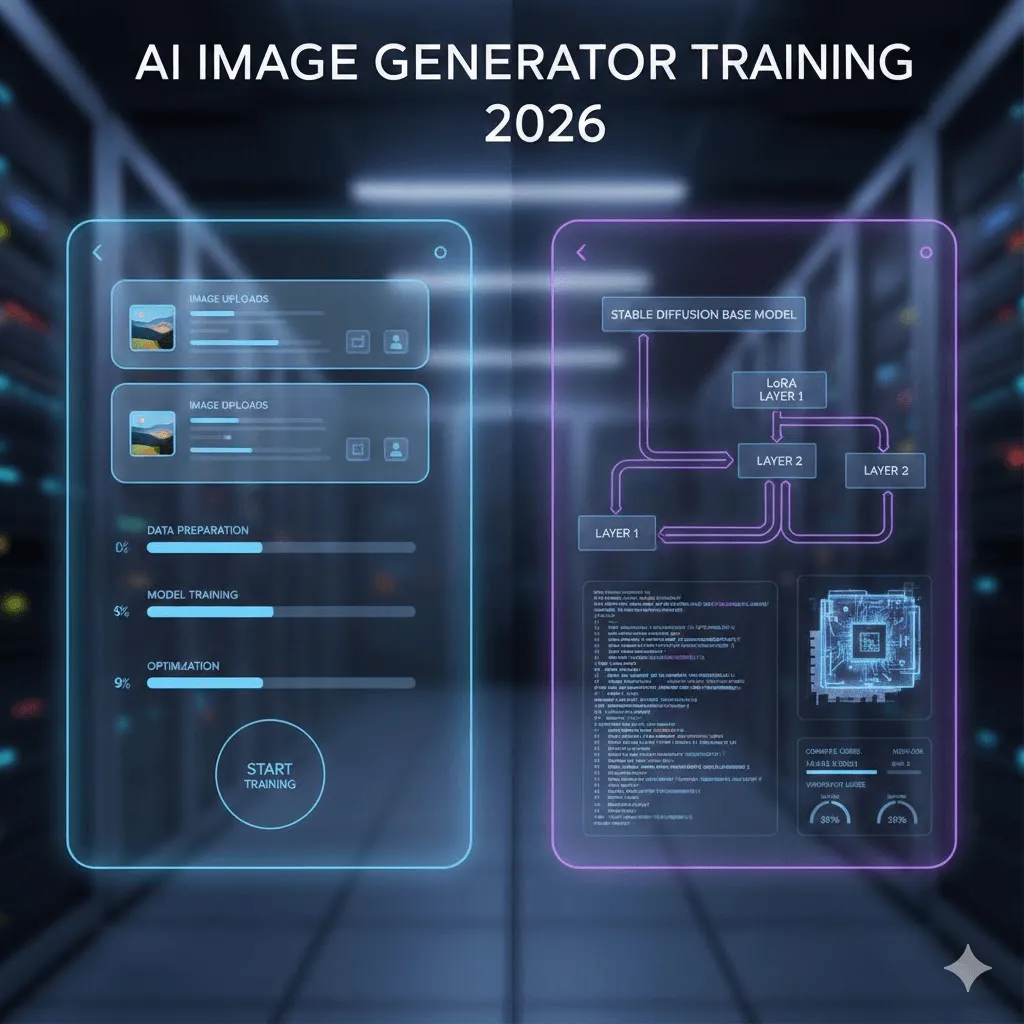

邁入 2026 年,訓練 AI 繪圖模型已不再是深奧的研究領域專利;過去需要具備深厚的機器學習背景、購置昂貴硬體並耗費數週反覆試驗,如今只要掌握正確方法,在短短一小時甚至不到 20 分鐘內即可迅速達成。

然而,並非所有「AI 訓練」的成效都一概而論。部分方案雖具備成本與速度優勢,卻在應用上有所侷限;而能提供完全掌控權的技術,則往往伴隨著較高的技術門檻。本指南將屏除誇大的行銷術語或過時資訊,根據現今最切實有效的實作經驗,為您詳盡剖析這兩種訓練路徑的利弊。

本指南將全面剖析兩大主流訓練路徑:既有專為效率追求者設計、僅需 20 分鐘且成本約 3 美元的無程式碼方案,亦有針對技術愛好者深入探討 DreamBooth、LoRA 及自定義訓練腳本的進階開發流程。我將憑藉實戰經驗,直言不諱地揭示各項技術的優劣與實際成效,並預先指引可能遇到的技術瓶頸,助您在模型微調的過程中少走冤枉路。

內容導覽

若您只想針對個人形象進行模型訓練並生成專屬 AI 影像,請直接跳轉至第三部分的 Replicate 實作教學。

若您是追求全面掌控權的開發者,建議直接從第四章「技術訓練」章節開始閱讀。

若您尚不確定該選擇哪種訓練方式,請由此開始深入了解。

1. 深度解析:究竟何謂 AI「模型訓練」?

首先需釐清一個常見的誤解:大眾所討論的「AI 繪圖模型訓練」,通常並非指從零開始建構模型,畢竟從頭訓練不僅需耗費數十萬美元的高昂成本,更得仰賴數據中心的龐大運算資源。

此過程的核心在於對現有模型進行微調。您可以將其理解為:在 Stable Diffusion 已具備繪製人物、產品與藝術風格的基礎上,透過 10 至 50 張範例圖片,進一步引導 AI 掌握您專屬的人物特徵、產品細節或獨特風格。

掌握自定義模型訓練:多元應用場景與實戰範例

人物與角色:藉由 18 張個人照片進行模型訓練,讓 AI 深度學習並精準掌握您的面部特徵。只需使用專屬觸發詞「ohw person」,即可隨心所欲地生成各種場景中的影像,無論是專業商務套裝、動感的衝浪姿態,甚至是轉化為卡通角色,皆能輕鬆實現。

產品應用:目前電商品牌已廣泛採用此技術,僅需透過 20 張不同角度的產品照片進行訓練,便能在各種虛擬場景中快速生成無限量的行銷素材,不僅製作靈活,成本更遠低於傳統的實體拍攝。

藝術風格:這項功能展現了極高的應用價值。只需提供約 30 張展現特定插畫風格的影像,系統便能精準掌握其視覺精髓並套用至全新的創作主題;目前已有許多專業工作室以此方式,為整體品牌打造出極具辨識度且風格統一的視覺美學。

2. 兩大訓練路徑:視需求選擇最適合您的方案

坦白說,對多數使用者而言,從無程式碼平台起步才是明智之舉。儘管開發者通常熱衷於親手處理每個細節,但除非您需要精確掌控自定義訓練參數,或渴望深入探究底層技術,否則選擇無程式碼路徑,僅需投入一成的精力,便能輕鬆收穫九成以上的卓越成果。

比較維度 | 無程式碼平台 | 技術導向路徑 |

首次產生成效時間 | 15 至 30 分鐘 | 3 至 8 小時(含環境部署與模型訓練) |

初期投入成本 | 每個模型約 2 至 10 美元 | 本地 GPU 零成本,或雲端運算約 0.5 至 5 美元 |

所需知識門檻 | 無需任何基礎,只需上傳相片即可開始 | 需掌握 Python、指令列操作及 GPU 運算邏輯 |

生成品質上限 | 表現極為優異,已能達成約 90% 的理想效果 | 透過精細參數調校,有潛力獲得更高品質 |

最佳適用場景 | 追求即時產出成果,且僅需訓練 1 至 5 個模型時 | 需規模化訓練 50 個以上模型、要求精確掌控或欲深研機器學習。 |

3. 高效捷徑:善用無程式碼平台啟動模型訓練

在深入實測五款不同平台後,我們將為您揭示其中真正有效的解決方案。

Replicate:我個人實測後推薦的最佳入門首選

每次模型訓練成本僅需約 2.50 美元,單張圖像的生成費用更低至約 0.03 美元。

訓練過程預計約需 18 至 25 分鐘即可完成

為什麼選擇 Replicate?在眾多工具中,它憑藉卓越的性價比脫穎而出,且介面設計簡潔直觀,省去了冗餘的複雜操作。使用者只需上傳影像即可快速啟動訓練流程,一氣呵成;更難能可貴的是,其開發文件清晰易讀,讓技術門檻大幅降低。

循序漸進:帶您深入探索最真實的實作流程,而非流於表面的行銷包裝

準備您的影像素材:

透過 18 張個人照片的實測心得,我發現訓練素材的「多樣性」遠比「數量」更為關鍵。初次嘗試時,我選用了 30 張角度雷同的大頭照,導致模型因過度擬合而僅能死板地重複特定姿勢;隨後我改用 18 張涵蓋不同視角、光影變化甚至全身構圖的照片,訓練出的生成效果明顯更為理想且靈活。

影像解析度建議至少為 512×512 像素,若採用 1024×1024 則能獲得更理想的訓練品質。同時請務必確保照片清晰無模糊,並避開過重的濾鏡或美顏修圖效果,好讓 AI 能夠精確學習您真實的面貌特徵,而非被過度磨皮修飾的人工版本。

資料上傳流程:

請先前往 replicate.com 完成註冊(提醒您,即使是使用免費方案亦需填寫支付資訊),並導覽至模型訓練區塊;在上傳素材時,您可以選擇逐張上傳或使用 ZIP 壓縮檔,若圖片數量超過 10 張,建議優先採用 ZIP 格式以獲得更高效的上傳體驗。

關鍵觸發詞(此環節對訓練成效至關重要):

為了確保訓練效果的精確性,建議選用一組獨特且罕見的識別碼(Unique Identifier),例如我便採用了以姓名縮寫組合而成的「ohw person」。請盡量避開「john」或「photo」等模型既有的常見詞彙,改用如「zxc person」這類較冷僻的詞組以有效區隔訓練資料。此外,平台會根據這些觸發指令自動為圖片生成標籤,讓您無需再手動進行繁瑣的標註作業,大幅提升模型訓練的效率。

模型訓練設定

在大多數情況下,建議優先採用系統預設。以 Replicate 為例,其預設的 800 次訓練步數已足以應對多數場景;雖然您可以手動微調,但初步訓練時建議先從預設值開始。若生成結果過於僵化、僅是機械式地複製訓練素材(即所謂的「過擬合」現象),建議下次訓練時將步數下調至 500 到 600 步之間。

漫長的等待:模型訓練的必經過程

以本次訓練 18 張圖片為例,整體過程約需 22 分鐘,完成後系統將自動發送電子郵件通知。需注意的是,介面上的進度預估較為理想,若顯示剩餘 5 分鐘,實際可能仍需約 10 分鐘方可完成。

模型效能實測與驗證

進入最令人期待的實測環節,建議先從基礎提示詞入手,在指令中加入觸發詞(Trigger Word),例如「一張 [ohw person] 微笑的照片」;待確認生成效果理想後,即可進一步發揮創意,嘗試將人物化身為超級英雄,或是生成穿著商務正裝的專業形象照。

專業技巧:善用「負面提示詞」(Negative Prompts)是提升生成品質的關鍵。藉由在欄位中加入「模糊、低畫質、變形、扭曲」等關鍵字,您能有效避免模型產生多餘手指或不自然的偽影,從而大幅優化最終的成像效果。

其他值得關注的優質平台

經實際測試評估,這些方案更適合針對特定使用情境進行優化:

getimg.ai: 雖然 getimg.ai 的單次訓練費用較高(約 8 至 10 美元),但其憑藉直觀優美的介面,並支援能在複雜場景中產出優異效果的 FLUX.1 訓練,對於追求專業品質的用戶來說是極具價值的投資。

Leonardo.Ai:專為遊戲開發者與概念藝術家量身打造,並提供免費方案供用戶初步測試。雖然其介面相較於 Replicate 而言較為繁複,但模型訓練品質表現穩定且極具水準。

ImagineArt:訓練流程極其高效,不到 15 分鐘即可完成,更整合了影片生成功能,讓您能直接為訓練好的角色注入動態生命。雖然這項功能尚待進一步完整測試,但目前展現的發展潛力相當值得期待。

4. 專業技術路徑:深入 Stable Diffusion 模型訓練

如果您決定挑戰難度較高的自定義模型訓練,這份勇於鑽研的精神確實令人敬佩。為了讓您免於像我一樣耗費大量時間處理 CUDA 報錯等技術難題,本文特別彙整了所有開發前必須掌握的核心心得,助您避開常見陷阱並大幅提升研發效率。

深入解析:為何掌握 AI 模型訓練技術至關重要?

誠然,並非每位使用者皆有此項需求,但在特定的專業應用場景下,其必要性顯而易見:

隨著訓練模型數量達到數十甚至上百個,無程式碼工具的累計成本將會隨之大幅攀升。

您需要掌握一般平台尚未對外開放的關鍵訓練參數,以實現更精準的模型微調。

針對必須嚴格保留在自有基礎設施內、嚴禁外流的專有數據處理需求。

深入洞察這項技術的核心運作邏輯,絕對是您掌握 AI 繪圖精髓最關鍵的一步。

三大核心訓練方法

DreamBooth:這項由 Google 研發的訓練技術,僅需透過 5 至 20 張影像並搭配獨特的識別標籤(Identifier Token),即可讓模型精準掌握特定的新視覺概念。DreamBooth 在處理人物及特定物件時表現尤為出色;即便原始論文顯示僅需 3 至 5 張素材即可運作,但在實務應用上,建議準備 15 至 20 張影像以確保生成的結果更穩定且具備一致性。

LoRA (Low Rank Adaptation):這項顛覆性的技術突破了傳統限制,無需修改動輒 5-7GB 的龐大原始模型,僅需建立 3-50MB 的微型「適配器」檔案即可完成。這不僅讓訓練速度大幅提升 3 至 5 倍,更使一般家用電競顯卡也能輕鬆運行,並產出足以媲美全量模型微調的高品質圖像。

這套結合 DreamBooth 與 LoRA 的方案,對於九成以上的技術使用者而言,是在訓練品質與資源效率之間取得完美平衡的理想首選。

全模型微調 (Full Fine Tuning):此技術涉及對整個模型進行訓練,因此對硬體設備有極高要求(顯示記憶體需達 24GB 以上)。事實上,除非有極其特殊的專業需求,否則 LoRA 僅需投入約一成的資源成本即可達到近九成五的成效;實測顯示,即便使用 A100 耗時六小時完成微調,其最終產出的品質與 LoRA 相比也並無顯著差異。

掌握訓練所需的關鍵要素

硬體規格解析:掌握模型訓練的核心效能需求

硬體配置方面,建議最低需具備 12GB 顯存的 NVIDIA GPU。儘管使用 RTX 3060 12GB 已足以應付 LoRA 訓練,但單次過程約需耗時 45 分鐘,效率稍顯不足;若追求更流暢的本地訓練體驗,配備 16GB 顯存的 RTX 4070 或 3080 則是兼具效能與速度的最佳首選。

針對缺乏硬體設備的使用者,RunPod 或 vast.ai 等雲端方案提供了單次訓練僅需 0.50 至 2 美元的實惠選擇;亦可考慮每月 10 美元的 Google Colab Pro 以獲取無限存取權限,儘管在尖峰時段可能需要排隊候位。

軟體工具

建議安裝 Python 3.10 或更高版本;由於實測中發現 3.11 版本仍存有部分相容性疑慮,建議優先選用穩定性較佳的 3.10 系列以確保系統順暢運行。

支援 CUDA 的 PyTorch

由 Hugging Face 推出的 diffusers 函式庫

運用 Accelerate、Transformers 及專為 LoRA 打造的 PEFT 技術,高效實現模型微調與優化。

DreamBooth 與 LoRA 核心訓練流程詳解

本指南將省略基礎的 Python 環境配置步驟,相信能閱讀至此的您已掌握基本的 pip 安裝技能,因此我們將直接深入探討真正關鍵的核心內容。

安裝程序(透過以下這行經實測且穩定有效的一行指令即可快速完成):

pip install diffusers[torch] transformers accelerate peft bitsandbytes

訓練腳本:

與其查閱冗長的程式碼,不如直接掌握關鍵要點:建議使用 Hugging Face 官方於 diffusers 儲存庫中提供的訓練腳本,這套腳本不僅維護完善且穩定可靠,以下為您彙整的核心參數:

學習率:經過實測,1e-4 是最理想的設定值;相較於反應過慢的 1e-5 或容易導致模型不穩定的 5e-4,建議優先採用 1e-4 以確保最佳的訓練平衡。

訓練步數:多數情況下建議設定在 800 至 1000 步之間,以確保模型能充分學習特徵,並避免因步數過少導致學習不足或因過多而產生過擬合風險。

批次大小:建議設定為 1 或 2,主要係考量到在進行 LoRA 訓練時,一般 GPU 的硬體資源往往難以負荷更高的數值。

LoRA 秩 (Rank):建議設定為 16 或 32。較高數值雖能提升模型容量,但訓練速度也會隨之放緩;通常 16 已足以精準捕捉面部特徵,若需呈現更複雜的藝術風格,則建議使用 32 以獲得更佳表現。

以下是我在實際操作中所運行的指令範例:

使用 accelerate launch 啟動 DreamBooth LoRA SDXL 訓練 \

預訓練模型名稱或路徑="stabilityai/stable diffusion xl base 1.0" \

instance_data_dir="./my_training_images" \

instance_prompt="一張 sks 人物的照片" \

將解析度設定為 1024 \

將訓練批次大小設定為 1 \

將學習率設定為 1e 4 \

max_train_steps=800 \

使用 LoRA 進行模型微調 \

lora_r=16 \

輸出目錄="./output_lora"

本次訓練在 RTX 3060 上耗時約 38 分鐘,若改用 RTX 4090 則可將時間進一步縮短至 15 分鐘內;而透過 Google Colab 的免費 T4 執行,預計則需花費 90 分鐘以上。

5. 訓練資料集準備:決定生成品質的核心關鍵

本章節之所以被列為重中之重,是因為多數指南往往會忽略這項核心關鍵:在模型訓練的過程中,高達 80% 的品質取決於數據集的優劣,而參數設定僅佔其餘的 20%。

實戰經驗總結:從反覆試錯中提煉的核心準則

建議將訓練圖片數量控制在 15 至 25 張的黃金區間。 雖然坊間常見 5 到 10 張的建議,但除非訓練目標極其簡單,否則這樣的規模往往難以保證品質;而過度增加至 40 張以上,通常不僅無法帶來實質提升,反而會徒增不必要的訓練耗時。

解析度是決定成效的關鍵:針對 SD 1.5 建議至少採用 512×512 規格,SDXL 則需達 1024×1024。請避免直接使用 4000×3000 等原始手機照片,因為過大的解析度並不會提升訓練品質,反而會降低效率,建議務必先行調整影像尺寸以確保訓練過程精確且高效。

多樣性遠比數量更為關鍵:這是不容忽視的核心原則,選用 15 張具備差異性的素材,其訓練成效往往優於 30 張雷同的圖片。建議廣泛涵蓋多元視角、光影與背景場景;若以人像為例,應同時收錄特寫與全身構圖,並納入豐富的表情及多變的服飾,方能讓模型學習到最全面的視覺特徵。

常見數據集訓練誤區:那些我曾親歷的實戰教訓

避免使用濾鏡或經編輯的照片:請務必捨棄 Instagram 濾鏡、美顏模式或各類重度後製影像,以免模型誤將濾鏡特效視為學習重點,進而無法精準捕捉並還原真實的主體特徵。

光源不統一:雖然訓練素材保有適度的差異性有其必要,但若光影條件過於極端(例如一半為明亮的戶外日光,另一半則是昏暗的室內燈光),將導致模型難以適應巨大落差而產生混淆。

排除畫面中的干擾人物:若您正針對個人模型進行訓練,請務必裁切掉照片中的其他人物,以避免模型在學習時混淆特徵;在先前的測試經驗中,僅因少數素材包含他人,模型便偶爾會誤將對方的髮型特徵融入生成結果。

浮水印與文字處理:由於模型訓練時會一併學習影像中的文字與浮水印,請務必在準備素材時將其移除或裁切,以確保生成結果的純淨度。

6. 全面解析實際成本投入

談到實際的開發與測試成本,以下為您詳細列出我在整個實測過程中所投入的真實花費明細:

服務平台 | 訓練費用 | 單張生成成本 | 綜合評析 |

Replicate | $2.47 | $0.028 | 性價比之冠,為預算首選 |

getimg.ai | $8.00 | $0.05~0.08 | 訓練 FLUX 模型之優質選擇 |

Leonardo.Ai | 免費至 $10 | 視方案而定 | 適合進行初步功能測試 |

Google Colab Pro | 每月 $10 不限次數 | $0 | 若有超過 10 個模型訓練需求最為划算 |

RunPod (RTX 3090) | 約 $0.80 | $0 (自行託管) | 開發者心目中的最佳平衡點 |

在地端 GPU | 僅需電費約 $0.15 | $0 | 若現有硬體設備充足則是不二之選 |

7. 疑難排解:應對訓練過程中可能出現的各類問題

以下彙整了我在實戰中遇到的真實挑戰與解決方案,助您避開常見難題並大幅提升訓練效率。

常見挑戰:模型生成效果過於僵化,僅是生硬地重現訓練素材

這就是所謂的「過擬合」(Overfitting)現象,導致當我下達「sks person at the beach」指令時,生成的影像幾乎只是機械式地將訓練原圖直接套用到海灘背景中。

實務成效分析

透過將訓練步數由 1000 步優化至 600 步,模型成效隨即顯著提升,從原本的死記硬背轉向更靈活的泛化處理;同時,藉由增加訓練素材的多樣性,也進一步優化了整體的生成品質。

核心挑戰:解決角色面貌與視覺風格難以統一的難題

生成的成果往往不盡相同,時而展現完美的細節還原,時而卻與訓練主體特徵大相徑庭。

實務成效分析

建議適度延長訓練時間,將訓練步數從 600 提升至 900 以強化成效;同時,撰寫提示詞時務必完整包含觸發詞(例如使用「sks person」而非單純的「person」),並在生成影像時將引導比例(CFG Scale)調升至 8 到 10 之間,以獲得更理想的產出結果。

常見挑戰:解決「CUDA Out of Memory」顯示記憶體不足的問題

本節內容專為技術人員設計,旨在協助您應對並解決 GPU 顯存(VRAM)不足的技術瓶頸。

常見問題快速修復方案:

請先將批次大小設定為 1,並同步啟用梯度檢查點 ( gradient_checkpointing 標記) 與混合精度技術 ( mixed_precision="fp16")。若訓練過程仍未成功,建議將解析度從 1024 降至 768,最後則可考慮採用 use_8bit_adam 方案。

解決模型訓練程序過於耗時的痛點

憶及首次使用 3060 顯示卡進行模型訓練時,長達兩小時的耗時確實顯得極其漫長且低效。

關鍵助力:

與其進行繁瑣的全面微調,不如改用效率提升達 5 倍的 LoRA 技術,並搭配 512px 解析度進行快速測試。透過將訓練步數精簡至 800 步,即可在大多數場景下達到理想效果;若追求極致效率,僅需支付 0.8 美元於 RunPod 租用 4090 顯卡運算 30 分鐘,讓每一分鐘的成本都能轉化為最高產能。

8. 關於 FLUX.1:深入探索新一代模型

由原 Stable Diffusion 核心團隊成員組成的 Black Forest Labs 於 2024 年中推出了 FLUX.1,這款模型在多數情境下的表現皆顯著超越了 SDXL,尤其在以下領域展現出卓越的優勢:

精準遵循各類複雜的提示指令

在影像中生成清晰可辨的文字(解決 SDXL 在此方面的顯著弱點)

影像的寫實質感與擬真度皆有顯著提升

有效減少畫面瑕疵與不自然的偽影,顯著改善如「多出手指」等常見的生成錯誤。

值得注意的是,高品質的訓練過程伴隨著較高的成本與硬體門檻,顯存(VRAM)需求建議達 20GB 以上。目前 getimg.ai 提供 FLUX 訓練服務,單一模型費用約 10 至 12 美元,Replicate 近期也已加入支援行列;若選擇本地訓練,則建議配備 RTX 4090 或租用高效能的運算資源。

這是否值得投入?對於追求極致品質的專業工作而言,答案無疑是肯定的;但若僅是為了個人專案或技術測試,SDXL 模型目前的表現依然相當出色,足以勝任各項需求。

結語

自定義 AI 繪圖模型的訓練在短短兩年內,便已從實驗室專屬的高門檻技術,演變為大眾在週末即可輕鬆完成的創作項目,其普及程度與發展速度之快,確實令人驚嘆。

以下是為您精選的實際建議操作路徑:

建議您先從 Replicate 平台入門,透過訓練單一模型來驗證成效是否符合預期;若已能滿足需求,則無需複雜操作。只有在您追求更精準的控制權,或需同時訓練多款模型時,才需進一步探索專業技術路徑。無需過度糾結,僅需備妥 15 張照片與 3 美元,即可輕鬆展開您的 AI 模型微調之旅。

隨著技術持續演進,即便 FLUX.1 表現已優於 SDXL,半年後也勢必會出現更強大的模型;與其空等所謂的「完美」工具,不如善用現有資源,從現在開始把握先機。

祝您訓練順利。請記住,即便是我當初的嘗試也難免有瑕疵,因此首個模型未臻完美也無須灰心,唯有透過親自實踐,才能在不斷摸索中掌握訣竅並持續進化。

深入探索 2026 年 11 款頂尖的 Ideogram 替代方案,全面評測其 AI 圖像生成技術、定價策略與多樣化的藝術風格表現。

深入探索 2026 年 11 款頂尖的 Ideogram 替代方案,全面評測其 AI 圖像生成技術、定價策略與多樣化的藝術風格表現。