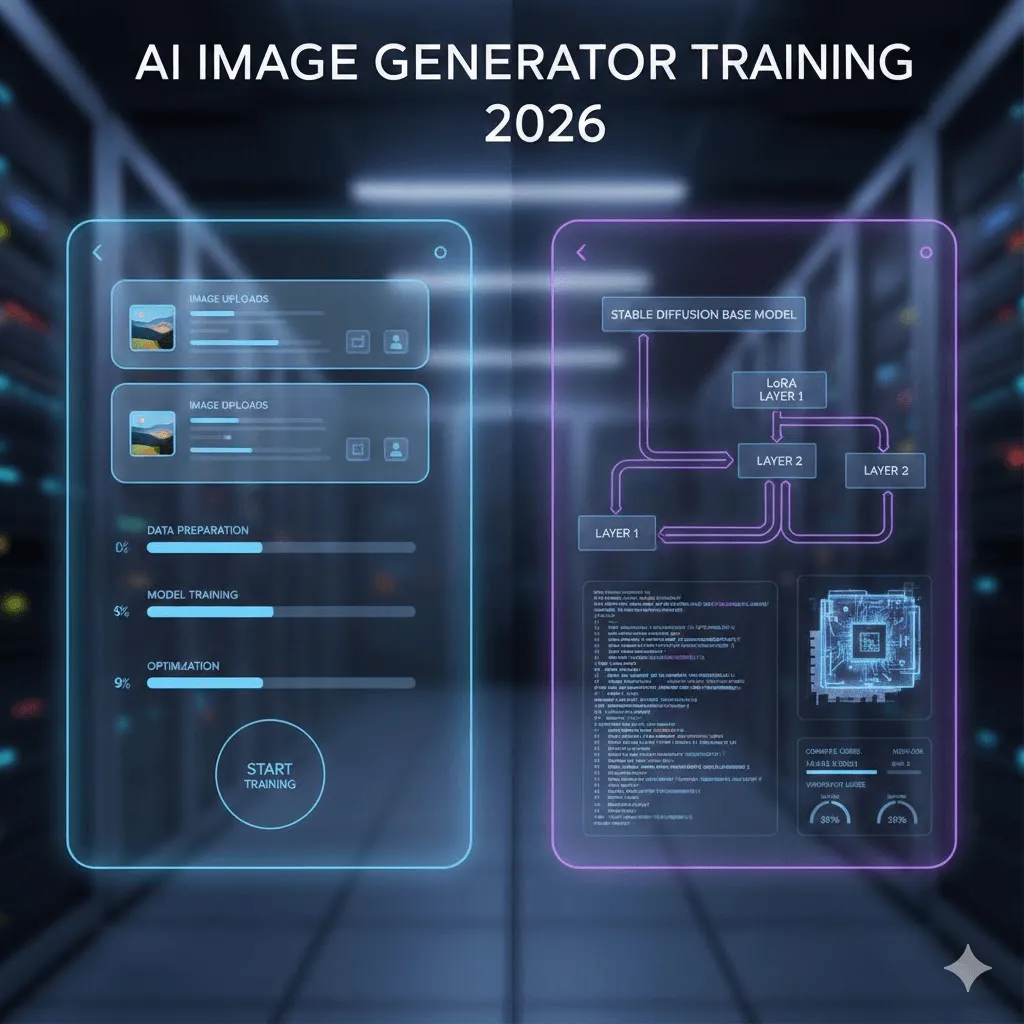

Guida all'addestramento di generatori di immagini IA nel 2026

Ultimo aggiornamento: 2026-01-22 18:08:26

Nel 2026, l’addestramento di un generatore di immagini IA non è più una competenza riservata esclusivamente alla ricerca accademica: processi che un tempo richiedevano conoscenze approfondite di machine learning, GPU costose e settimane di test, possono oggi essere completati in meno di un’ora — e talvolta in soli venti minuti — individuando il percorso tecnologico più adatto alle proprie esigenze.

Tuttavia, è fondamentale comprendere che non tutti i metodi per allenare i modelli di IA sono uguali: se alcune soluzioni puntano su rapidità ed economicità a scapito della flessibilità, altre garantiscono un controllo totale pur richiedendo una gestione tecnica più complessa. Questa guida analizza con trasparenza entrambi i percorsi, basandosi esclusivamente su ciò che è realmente efficace oggi, lontano da promesse di marketing o tutorial ormai superati.

Questa guida analizza nel dettaglio entrambi gli approcci: il percorso senza codice, che consente di addestrare un modello in appena 20 minuti con un costo di circa 3 dollari, e la via tecnica, dedicata a chi vuole cimentarsi con DreamBooth, LoRA e script di addestramento personalizzati. In questo manuale condividerò con estrema trasparenza soluzioni e potenziali ostacoli, basandomi sull'esperienza diretta maturata sul campo durante il processo di ottimizzazione.

Indice rapido

Se desideri creare un modello personalizzato sulla tua immagine e iniziare subito a generare foto con l’IA, consulta direttamente la Sezione 3 relativa al tutorial di Replicate.

Gli sviluppatori che desiderano un controllo totale sul processo possono consultare direttamente la Sezione 4, dedicata all'addestramento tecnico del modello.

Se non avete ancora individuato l'approccio più indicato, vi invitiamo a proseguire nella lettura per scoprire la soluzione ideale per le vostre esigenze.

1. Cosa significa realmente "allenare" un modello di IA?

Per fare chiarezza su un punto spesso oggetto di confusione, è bene precisare che parlare di "allenare un generatore di immagini IA" non significa quasi mai creare un modello da zero, un'operazione che richiederebbe investimenti per centinaia di migliaia di dollari e l'impiego di interi data center.

L'operazione consiste nell'eseguire il fine-tuning di un modello preesistente: sfruttando la capacità nativa di Stable Diffusion di rappresentare persone, prodotti e stili artistici, potrete addestrare il sistema a riconoscere il VOSTRO specifico soggetto o stile attraverso l'impiego di appena 10-50 immagini di esempio.

Cosa è possibile addestrare: esempi pratici e reali

Persone e personaggi: Attraverso l'addestramento del modello basato su soli 18 scatti personali, è possibile generare la propria immagine in scenari infiniti, dal surf agli abiti formali fino alla trasformazione in un cartone animato. Grazie alla capacità del sistema di apprendere i tratti somatici distintivi, basta utilizzare una parola di attivazione specifica, come "ohw person", per integrare perfettamente il proprio volto in ogni creazione.

Prodotti: Sempre più adottata dai brand di e-commerce, questa soluzione permette di addestrare il modello caricando circa 20 foto del prodotto da diverse angolazioni, così da generare infiniti scatti di marketing in qualsiasi ambientazione con un risparmio significativo rispetto ai tradizionali servizi fotografici.

Stili artistici: una funzione particolarmente interessante che, attraverso l'elaborazione di circa 30 campioni del proprio stile illustrativo, permette di replicare fedelmente tale estetica su soggetti inediti, offrendo agli studi creativi una soluzione avanzata per declinare coerentemente l'intera identità visiva del proprio brand.

Scopri l'analisi comparativa più completa del 2026 tra i generatori di immagini AI Ideogram e Midjourney, con un approfondimento sulle funzionalità creative e sull'evoluzione delle strategie di prezzo.

2. Due percorsi strategici: scegli la soluzione ideale in base alle tue necessità

A dire il vero, la scelta più sensata per la maggior parte degli utenti è iniziare con piattaforme no-code. Sebbene chi sviluppa tenda spesso a prediligere soluzioni interamente personalizzate, il percorso senza codice permette di ottenere il 90% dei risultati con appena il 10% dello sforzo, rivelandosi la soluzione più efficiente a meno che non si necessiti di specifici parametri di addestramento o si desideri approfondire la tecnologia sottostante.

Scopri l'analisi comparativa più completa del 2026 tra i generatori di immagini AI Ideogram e Midjourney, con un approfondimento sulle funzionalità creative e sull'evoluzione delle strategie di prezzo.

Fattore | Piattaforme No-Code | Approccio Tecnico |

Velocità di esecuzione | Dai 15 ai 30 minuti | Dalle 3 alle 8 ore (configurazione e addestramento) |

Investimento iniziale | 2-10 $ per modello | Gratuito (GPU locale) o 0,50-5 $ (cloud) |

Competenze richieste | Nessuna; è sufficiente caricare le proprie foto | Python, riga di comando e architettura GPU |

Potenziale qualitativo | Eccellente (resa ottimale nel 90% dei casi) | Superiorità potenziale tramite ottimizzazione manuale |

Quando sceglierlo | Per chi necessita di risultati immediati e addestra 1-5 modelli | Per addestramenti massivi (oltre 50 modelli), controllo granulare o studio del ML |

3. La via rapida: addestramento e fine-tuning tramite piattaforme No-Code

Dopo aver analizzato e testato cinque diverse piattaforme, abbiamo selezionato le soluzioni che si sono dimostrate realmente efficaci.

Replicate: il punto di partenza ideale e la soluzione d’elezione che ho adottato

L'investimento previsto è estremamente contenuto, con un costo di circa 2,50 $ per sessione di addestramento e appena 0,03 $ per ogni immagine generata.

Il processo di addestramento viene ultimato in un arco di tempo compreso tra i 18 e i 25 minuti.

Perché scegliere proprio Replicate? Oltre a offrire uno dei migliori rapporti qualità-prezzo sul mercato, la piattaforma si distingue per un'interfaccia essenziale ed efficace che semplifica l'intero processo: è sufficiente caricare le proprie immagini per completare l'addestramento. A questo si aggiunge una documentazione tecnica estremamente chiara e fruibile, un valore aggiunto raro e prezioso in questo settore.

Guida passo-passo: il processo operativo reale, oltre le semplificazioni del marketing

Preparazione delle immagini:

Sulla base della mia esperienza con 18 scatti personali, ho imparato che la varietà degli asset è un fattore ben più determinante della semplice quantità: se un primo test con 30 foto troppo simili tra loro aveva spinto il modello a una sterile memorizzazione delle pose, il secondo tentativo — basato su 18 immagini differenziate per angolazione, illuminazione e inquadrature a figura intera — ha garantito una flessibilità generativa decisamente superiore.

Per quanto riguarda le specifiche tecniche, sebbene il requisito minimo sia di 512×512 pixel, l'adozione di una risoluzione di 1024×1024 ottimizza sensibilmente la resa finale; è inoltre essenziale evitare immagini sfocate, poiché l'intelligenza artificiale non può apprendere efficacemente da ciò che non risulta nitido. Si raccomanda infine di non utilizzare filtri marcati o applicazioni di bellezza per lo smoothing, garantendo così che il modello riconosca i vostri tratti autentici anziché una versione artificialmente alterata.

Scopri l'analisi comparativa più completa del 2026 tra i generatori di immagini AI Ideogram e Midjourney, con un approfondimento sulle funzionalità creative e sull'evoluzione delle strategie di prezzo.

La procedura di caricamento:

Inizia accedendo a replicate.com per completare la registrazione del tuo account, tenendo presente che l'inserimento di un metodo di pagamento è richiesto anche per l'accesso al piano gratuito. Una volta raggiunta la sezione dedicata all'addestramento, potrai procedere al caricamento delle immagini singolarmente oppure, per una gestione più rapida ed efficiente di set superiori ai dieci file, tramite un unico archivio ZIP.

La parola di attivazione (Trigger Word): un elemento di fondamentale importanza

Per ottenere risultati ottimali, è fondamentale scegliere un identificatore univoco e distintivo come "ohw person", evitando termini generici quali "john" o "photo" già presenti nel database di addestramento del modello. Grazie all'automazione della piattaforma, le didascalie verranno generate basandosi su questi trigger specifici, semplificando il processo ed eliminando la necessità di procedere manualmente all'etichettatura di ogni immagine.

Configurazioni di addestramento:

Nella maggior parte dei casi, l'approccio più efficace consiste nell'affidarsi alle impostazioni predefinite, come gli 800 passi di addestramento suggeriti da Replicate, che garantiscono risultati ottimali nella quasi totalità degli scenari. Sebbene sia possibile personalizzare questi parametri, è consigliabile iniziare dai valori standard: qualora l'output dovesse replicare in modo eccessivamente letterale le immagini originali — un fenomeno tecnico definito overfitting — suggeriamo di ridurre i passi a una soglia compresa tra 500 e 600 per le sessioni successive.

L'attesa dei risultati:

L'addestramento di un set composto da 18 immagini richiede circa 22 minuti, al termine dei quali riceverai una notifica automatica via email; tuttavia, è bene considerare che la barra di avanzamento tende a essere ottimistica, raddoppiando spesso i tempi effettivamente previsti negli ultimi istanti.

Scopri l'analisi comparativa più completa del 2026 tra i generatori di immagini AI Ideogram e Midjourney, con un approfondimento sulle funzionalità creative e sull'evoluzione delle strategie di prezzo.

Verifica e test del modello:

È giunto il momento di dare spazio alla creatività: inizia con un prompt semplice come "a photo of ohw person smiling" per testare la tua trigger word e, una volta verificata l'efficacia, sperimenta scenari più complessi, trasformando il soggetto in un supereroe o generando un ritratto professionale in abiti formali.

Un suggerimento fondamentale per elevare la qualità delle immagini consiste nell’utilizzo dei prompt negativi: inserendo termini quali "blurry, low quality, deformed, distorted" nell’apposito campo, è possibile ottimizzare drasticamente i risultati, prevenendo la generazione di artefatti indesiderati o anomalie anatomiche, come le dita in eccesso, che il modello potrebbe altrimenti introdurre.

Altre piattaforme degne di nota

Sebbene siano state oggetto di test approfonditi, queste soluzioni offrono i migliori risultati se impiegate per specifici casi d'uso:

getimg.ai: Pur avendo un prezzo superiore (circa 8-10 $ per modello), questa piattaforma offre un'interfaccia estremamente curata e supporta l'addestramento FLUX.1, che garantisce risultati sensibilmente migliori nelle scene complesse e la rende la scelta ideale per un utilizzo professionale.

Leonardo.Ai: Pensato per sviluppatori di videogiochi e concept artist, Leonardo.Ai mette a disposizione un piano gratuito per testarne le potenzialità e assicura una solida qualità di addestramento, sebbene presenti un'interfaccia più complessa rispetto a Replicate.

ImagineArt: offre cicli di addestramento rapidi, completabili in meno di 15 minuti, e integra funzionalità di generazione video per animare i propri personaggi; sebbene la funzione sia ancora in fase di test, i risultati preliminari appaiono estremamente promettenti.

4. L'approccio tecnico: addestramento con Stable Diffusion

Se avete deciso di intraprendere il percorso più tecnico e complesso, questa guida raccoglie tutti gli approfondimenti fondamentali che avremmo voluto conoscere prima di affrontare lunghe sessioni dedicate alla risoluzione degli errori CUDA.

Perché investire nell'addestramento tecnico dei modelli?

Siamo onesti: sebbene per la maggior parte degli utenti questa procedura non sia strettamente necessaria, esistono scenari d’uso specifici e valide ragioni tecniche che ne giustificano l'adozione:

L'addestramento di decine o centinaia di modelli comporta un inevitabile aumento dei costi, specialmente quando ci si affida a soluzioni no-code.

L'addestramento avanzato richiede parametri di configurazione specifici che le piattaforme standard solitamente non rendono accessibili.

Gestite dati proprietari che devono rimanere confinati all'interno della vostra infrastruttura

Comprendere a fondo le logiche di funzionamento di questa tecnologia rappresenta un obiettivo ambizioso e del tutto giustificato.

Le tre metodologie principali

DreamBooth: Sviluppato da Google, questo metodo permette di istruire il modello su nuovi "concetti" utilizzando da 5 a 20 immagini abbinate a un identificativo univoco, risultando particolarmente efficace per la riproduzione di volti e oggetti specifici. Sebbene la ricerca originale dimostri la validità del sistema con soli 3-5 scatti, l’esperienza pratica suggerisce di impiegarne tra i 15 e i 20 per ottenere una coerenza visiva superiore e risultati più prevedibili.

LoRA (Low Rank Adaptation): Vera e propria rivoluzione tecnologica, questa soluzione evita la modifica di interi file di modello da 5-7 GB creando invece un "adattatore" estremamente leggero (3-50 MB), capace di garantire una qualità pressoché indistinguibile dal fine-tuning completo. Grazie a questo approccio, l'addestramento risulta dalle 3 alle 5 volte più rapido e può essere eseguito agevolmente su una comune GPU da gaming.

Consiglio questo approccio alla stragrande maggioranza degli utenti tecnici, poiché l'integrazione tra DreamBooth e LoRA rappresenta il perfetto punto di equilibrio tra efficacia e versatilità.

Fine-tuning completo del modello: Questa procedura richiede un hardware professionale con oltre 24 GB di VRAM per l'addestramento dell'intera architettura; tuttavia, salvo esigenze estremamente specifiche, la tecnica LoRA garantisce circa il 95% della resa ottimale impiegando appena il 10% delle risorse. Test diretti su GPU A100 hanno richiesto oltre sei ore di elaborazione, senza però produrre risultati significativamente superiori rispetto ai vantaggi offerti da un approccio LoRA.

Tutto ciò di cui hai realmente bisogno

Requisiti hardware: le specifiche tecniche indispensabili

Per quanto concerne i requisiti hardware, è necessaria almeno una GPU NVIDIA con 12 GB di VRAM: sebbene una RTX 3060 consenta di gestire l'addestramento LoRA in circa 45 minuti, per un training locale ottimale si consiglia di optare per modelli come la RTX 4070 o la 3080 dotati di 16 GB.

In assenza di una GPU dedicata, è possibile affidarsi a servizi cloud come RunPod o vast.ai con costi compresi tra 0,50 e 2 dollari per sessione, oppure optare per Google Colab Pro che, al costo di 10 dollari mensili, garantisce un accesso illimitato pur prevedendo tempi di attesa nelle ore di punta.

Software:

Si raccomanda l'uso di Python 3.10 o versioni successive, sebbene la release 3.11 abbia mostrato alcune criticità di compatibilità durante i test di implementazione.

PyTorch con supporto CUDA

La libreria diffusers di Hugging Face

Sfrutta l'integrazione delle librerie Accelerate e Transformers, utilizzando PEFT per un addestramento LoRA altamente ottimizzato.

Il processo di addestramento: fine-tuning tramite DreamBooth e LoRA

Ometteremo i passaggi relativi alla configurazione di base dell'ambiente Python per concentrarci esclusivamente sugli aspetti tecnici più rilevanti, presupponendo che abbiate già familiarità con l'installazione delle dipendenze e la gestione dei pacchetti.

Installazione rapida: il comando a riga singola per una configurazione immediata e senza errori:

pip install diffusers[torch] transformers accelerate peft bitsandbytes

Script di addestramento:

Anziché proporre complessi blocchi di codice, abbiamo riassunto le informazioni essenziali per guidarvi al meglio: la soluzione più affidabile consiste nell'utilizzare lo script di addestramento ufficiale disponibile nel repository "diffusers" di Hugging Face, una risorsa costantemente aggiornata e collaudata. Ecco i parametri fondamentali da considerare:

Learning rate: il valore ottimale è fissato a 1e~4, poiché impostazioni inferiori come 1e~5 risultano eccessivamente lente, mentre parametri più elevati come 5e~4 rischiano di compromettere la stabilità del modello.

Passaggi di addestramento: Nella maggior parte dei casi l’intervallo ideale è compreso tra 800 e 1000 step, poiché una soglia inferiore impedirebbe un apprendimento adeguato del modello, mentre un numero eccessivo esporrebbe al rischio di overfitting.

Dimensione del batch: Si suggerisce un valore di 1 o 2, poiché i limiti di memoria della GPU difficilmente consentirebbero di gestire carichi di lavoro superiori durante l'addestramento LoRA.

Rank LoRA: si consiglia di impostare valori tra 16 e 32, poiché a una maggiore capacità di apprendimento corrisponde una velocità ridotta; nello specifico, il valore 16 risulta ideale per i volti, mentre il 32 è preferibile per gestire stili artistici complessi.

Scopri l'analisi comparativa più completa del 2026 tra i generatori di immagini AI Ideogram e Midjourney, con un approfondimento sulle funzionalità creative e sull'evoluzione delle strategie di prezzo.

Esempio del comando effettivamente utilizzato durante la procedura:

accelerate launch train_dreambooth_lora_sdxl.py \

pretrained_model_name_or_path="stabilityai/stable diffusion xl base 1.0" \

instance_data_dir="./mie_immagini_addestramento" \

instance_prompt="una foto del soggetto sks" \

risoluzione=1024 \

train_batch_size=1 \

learning_rate=1e 4 \

max_train_steps=800 \

Utilizzo di LoRA \

lora_r=16 \

output_dir="./output_lora"

Il completamento del processo ha richiesto 38 minuti su una RTX 3060, ma la tempistica scenderebbe sotto i 15 minuti con una 4090, mentre l'utilizzo della GPU T4 gratuita di Google Colab richiederebbe oltre 90 minuti.

5. Preparazione del dataset: il fattore cruciale per il successo del modello

Abbiamo scelto di evidenziare subito questo aspetto poiché rappresenta il pilastro fondamentale dell'intero processo, spesso trascurato nelle guide tradizionali: la qualità finale dell'addestramento è determinata per l'80% dal dataset utilizzato, mentre le impostazioni tecniche influiscono solo per il restante 20%.

Le regole fondamentali: le lezioni apprese sul campo

L'intervallo ottimale si attesta tra le 15 e le 25 immagini: sebbene vengano spesso consigliati set ridotti da 5-10 scatti, questi risultano sufficienti solo per soggetti estremamente semplici, mentre l'impiego di oltre 40 immagini tende a prolungare i tempi di elaborazione senza apportare benefici qualitativi tangibili.

L'importanza della risoluzione: è fondamentale impostare un formato minimo di 512×512 per SD 1.5 e di 1024×1024 per SDXL. È preferibile evitare l'uso diretto di foto da smartphone ad alta risoluzione, come i 4000×3000, procedendo invece a un ridimensionamento preventivo per garantire la massima efficienza durante l'addestramento del modello.

La varietà prevale sulla quantità: un principio fondamentale secondo cui 15 immagini eterogenee superano per efficacia 30 scatti simili tra loro. Per ottimizzare l'addestramento, è essenziale diversificare angolazioni, luci e contesti; nel caso di un soggetto umano, ad esempio, occorre alternare primi piani e figure intere, includendo una vasta gamma di espressioni e stili di abbigliamento.

Gli errori più comuni nella preparazione dei dataset: lezioni apprese dall'esperienza diretta

L'impiego di immagini filtrate o modificate: è fondamentale evitare l'uso di filtri social, modalità bellezza o ritocchi eccessivi, poiché il modello finirebbe per assimilare gli effetti estetici anziché i tratti autentici del soggetto.

Illuminazione incoerente: Sebbene una moderata variabilità sia consigliata, un contrasto eccessivo tra scatti in piena luce naturale e immagini in ambienti scarsamente illuminati rischia di confondere il modello, compromettendo l'efficacia del processo di apprendimento.

Presenza di più soggetti nell’inquadratura: Qualora l’addestramento sia focalizzato su un profilo specifico, è fondamentale ritagliare le immagini per escludere altre persone, onde evitare che il modello ne assimili erroneamente i tratti somatici. L'esperienza dimostra infatti che l'inclusione di soggetti terzi anche in soli tre scatti può compromettere la precisione del risultato, portando l'IA ad attribuire al protagonista caratteristiche estranee, come l’acconciatura di un altro individuo presente nel dataset.

Filigrane e testi: per evitare che il modello li assimili durante l'addestramento, è fondamentale rimuoverli o ritagliarli preventivamente dal set di dati.

Scopri l'analisi comparativa più completa del 2026 tra i generatori di immagini AI Ideogram e Midjourney, con un approfondimento sulle funzionalità creative e sull'evoluzione delle strategie di prezzo.

6. Analisi dettagliata dei costi effettivi

Passiamo ora all'analisi dei costi per esaminare nel dettaglio l'investimento effettivamente richiesto durante le nostre fasi di test.

Scopri l'analisi comparativa più completa del 2026 tra i generatori di immagini AI Ideogram e Midjourney, con un approfondimento sulle funzionalità creative e sull'evoluzione delle strategie di prezzo.

Piattaforma | Costo addestramento | Costo per immagine | La nostra valutazione |

Replicate | 2,47 $ | 0,028 $ | Il miglior rapporto qualità-prezzo |

getimg.ai | 8,00 $ | 0,05 ~ 0,08 $ | Investimento giustificato per FLUX |

Leonardo.Ai | Da gratuito a 10 $ | Variabile | Ideale per fasi di test |

Google Colab Pro | 10 $/mese (illimitato) | 0 $ | Ottimale per l'addestramento di oltre 10 modelli |

RunPod (RTX 3090) | ~0,80 $ | 0 $ (self-hosted) | La scelta prediletta dagli sviluppatori |

GPU Locale | ~0,15 $ (consumo elettrico) | 0 $ | Consigliato per chi dispone dell'hardware necessario. |

7. Risoluzione dei problemi: gestire le criticità e gli imprevisti tecnici

Di seguito illustrerò le criticità effettivamente riscontrate e le relative soluzioni implementate, fornendoti indicazioni preziose per ottimizzare il tuo lavoro ed evitarti inutili complicazioni.

Problema: il modello si limita a replicare fedelmente le foto di addestramento

Questo fenomeno, definito overfitting, si manifesta quando, inserendo un prompt come "sks person at the beach", il sistema riproduce quasi fedelmente l'immagine originale utilizzata per l'addestramento, limitandosi a trasporla in un contesto balneare.

Le soluzioni rivelatesi efficaci:

Riducendo i cicli di addestramento da 1000 a 600, si ottiene un miglioramento immediato: il modello smette di limitarsi alla semplice memorizzazione per iniziare a generalizzare con efficacia, un’evoluzione favorita anche dall'integrazione di una maggiore varietà nel set di dati.

Il problema dell'incoerenza stilistica e dei volti

Nonostante si possano talvolta ottenere risultati impeccabili, capita spesso che l’immagine generata fatichi a riflettere con precisione le caratteristiche del soggetto originale.

Le soluzioni rivelatesi efficaci:

Per perfezionare i risultati, si consiglia di estendere la durata dell'addestramento incrementando il numero di step, ad esempio da 600 a 900; è inoltre fondamentale che la "trigger word" sia sempre inclusa nel prompt — utilizzando formule specifiche come "sks person" anziché un generico "person" — e che la guidance scale (CFG) venga impostata tra 8 e 10 durante la fase di generazione.

Risoluzione dell'errore "CUDA Out of Memory"

Dedicato ai profili più tecnici, questo approfondimento affronta la problematica dell'esaurimento della memoria VRAM della GPU.

Soluzioni rapide:

Per ottimizzare le prestazioni, imposta la dimensione del batch a 1 e abilita il flag gradient_checkpointing, adottando la precisione mista ( mixed_precision="fp16"). Qualora riscontrassi ancora errori, prova a ridurre la risoluzione da 1024 a 768 o, come soluzione estrema, ad attivare l'opzione use_8bit_adam.

Il problema dei tempi di addestramento eccessivamente lunghi

La mia prima esperienza di addestramento su una 3060 ha richiesto ben due ore, una tempistica decisamente eccessiva e inefficiente per i flussi di lavoro attuali.

Elementi chiave per il successo:

Per massimizzare l'efficienza, scegliete la tecnica LoRA anziché il fine-tuning completo per velocizzare l'addestramento di ben cinque volte, limitando la risoluzione a 512px e gli step a circa 800 durante le fasi di test. Qualora il tempo sia una priorità, è possibile investire appena 0,80 $ per una sessione di 30 minuti su RunPod con una GPU 4090, ottenendo prestazioni elevate con un costo contenuto.

8. Uno sguardo a FLUX.1: le potenzialità del modello di ultima generazione

Lanciato a metà del 2024 da Black Forest Labs — realtà che riunisce parte del team originale di Stable Diffusion — FLUX.1 supera nettamente le prestazioni di SDXL nella maggior parte degli scenari, dimostrandosi particolarmente efficace per:

Interpretazione precisa e fedele di prompt articolati e complessi.

Generazione di testi leggibili nelle immagini, superando le ben note limitazioni di SDXL in questo ambito.

La qualità del fotorealismo è stata sensibilmente perfezionata, offrendo una resa visiva nettamente superiore.

Elimina gli artefatti visivi e perfeziona la resa anatomica, riducendo drasticamente anomalie comuni come le dita in eccesso.

Tuttavia, l'addestramento richiede un investimento maggiore e requisiti hardware superiori, con una VRAM consigliata di almeno 20 GB. Mentre piattaforme come getimg.ai offrono il supporto ai modelli FLUX a un costo di circa 10-12 $ e Replicate ha recentemente introdotto questa funzionalità, chi preferisce l'elaborazione in locale dovrà dotarsi di una GPU di fascia alta come la RTX 4090 o optare per il noleggio di infrastrutture ad alte prestazioni.

Sebbene SDXL rappresenti ancora una soluzione eccellente per progetti personali e fasi di test, l'adozione di queste tecniche risulta un investimento indispensabile per chi opera in contesti professionali o necessita di standard qualitativi superiori.

Considerazioni finali

In soli due anni, l'addestramento di generatori di immagini IA personalizzati si è evoluto da una tecnologia riservata ai laboratori di ricerca a un'attività alla portata di chiunque, rendendo questo processo straordinariamente accessibile.

Di seguito illustriamo il percorso metodologico consigliato:

Il punto di partenza ideale è Replicate: addestra un primo modello per testarne l'efficacia e, se i risultati soddisfano le tue necessità, il processo si conclude qui. Solo qualora desiderassi un controllo maggiore o dovessi gestire decine di modelli, ti consigliamo di esplorare percorsi tecnici più avanzati; evita però ogni esitazione, poiché bastano appena 15 foto e un investimento di 3 dollari per iniziare subito a sperimentare.

In un panorama tecnologico in costante evoluzione, dove FLUX.1 ha già superato le prestazioni di SDXL e nuovi standard d'eccellenza emergeranno nel giro di pochi mesi, attendere il modello perfetto sarebbe controproducente: il momento ideale per iniziare a sperimentare con le soluzioni attualmente a disposizione è adesso.

Buon lavoro e ricordate: è assolutamente normale che il primo modello non sia perfetto, proprio come non lo è stato il mio, poiché la vera padronanza si acquisisce solo attraverso la sperimentazione e la pratica costante.

Esplora le 11 migliori alternative a Ideogram del 2026: una guida ai più avanzati generatori di immagini AI che analizza prezzi, stili artistici e capacità di rendering del testo per aiutarti a trovare lo strumento creativo perfetto.

Esplora le 11 migliori alternative a Ideogram del 2026: una guida ai più avanzati generatori di immagini AI che analizza prezzi, stili artistici e capacità di rendering del testo per aiutarti a trovare lo strumento creativo perfetto.

Scopri l'analisi comparativa più completa del 2026 tra i generatori di immagini AI Ideogram e Midjourney, con un approfondimento sulle funzionalità creative e sull'evoluzione delle strategie di prezzo.